Cuando un niño con un boli supera a miles de millones en IA

realización: 27 de enero de 2026 | actualización: 27 de enero de 2026

Imagina la siguiente escena:

convocas a los nietos de los miembros de los consejos de administración de

los mayores inversores en IA del mundo,

les entregas una hoja y un bolígrafo, y

les planteas un problema de un diagrama de flujo que

cualquier niño de 10 años resuelve en minutos.

Mientras tanto, los sistemas de IA más avanzados y costosos del planeta

fallan estrepitosamente.

Los abuelos cogen el teléfono y le dicen al CEO: «vende».

Esto no es ficción.

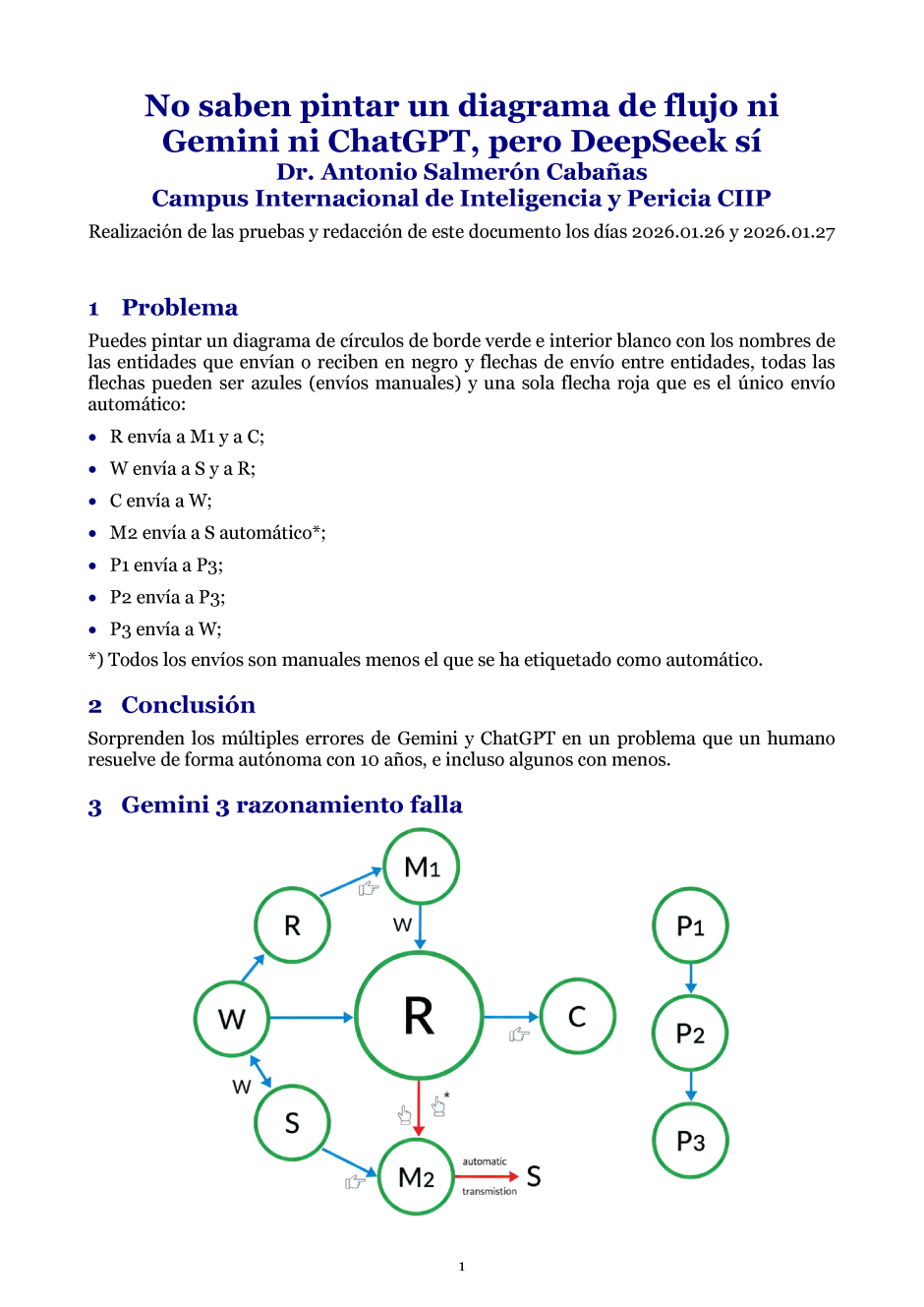

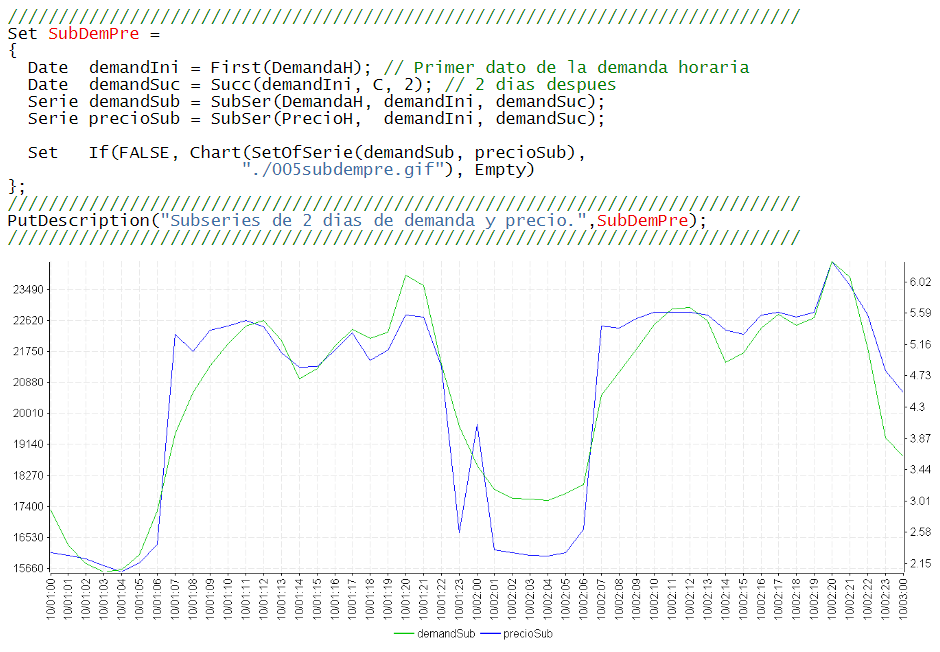

He sometido a 3 de los modelos líderes

(Gemini 3, ChatGPT 5.2 y DeepSeek) a una prueba elemental:

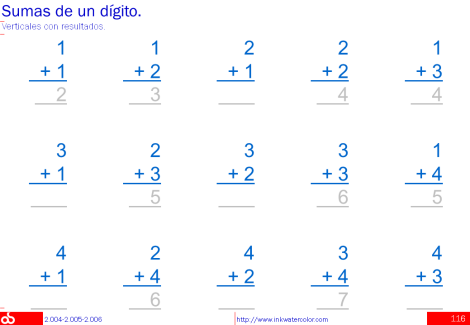

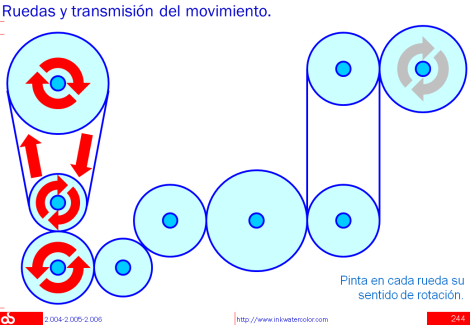

pintar un diagrama

de círculos con bordes verdes e interiores blancos,

nombres de entidades en negro, y

flechas azules para envíos manuales y

una roja para el único automático.

Las relaciones eran triviales:

- R envía a M1 y C;

- W envía a S y R;

- C envía a W;

- M2 envía a S (automático);

- P1 y P2 envían a P3;

- P3 envía a W.

Resultado:

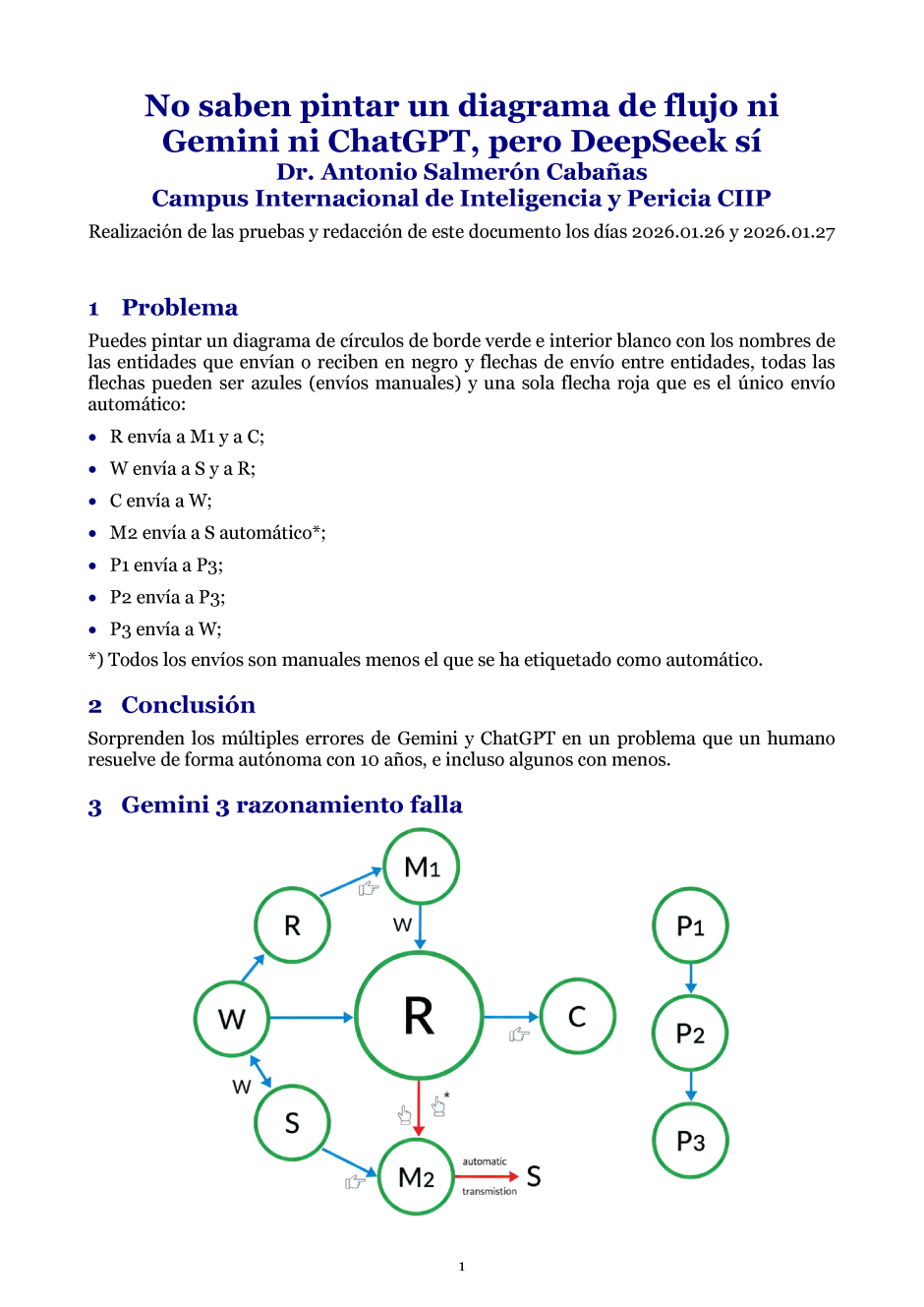

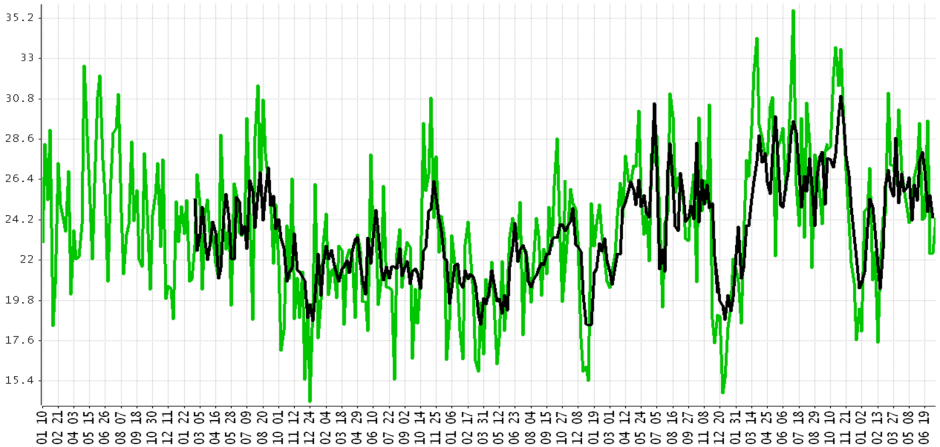

Gemini 3 (tanto en modo rápido como razonamiento) pintó

un diagrama erróneo e inconexo.

ChatGPT 5.2 falló igualmente.

Solo DeepSeek lo resolvió correctamente,

aunque su herramienta de representación pintó rectángulos en lugar de círculos.

2 gigantes tecnológicos derrotados por un problema de primaria.

Lo preocupante no es solo que fallen,

sino que lo hagan en algo tan elemental,

aparentando una contradicción con su capacidad de razonamiento lógico.

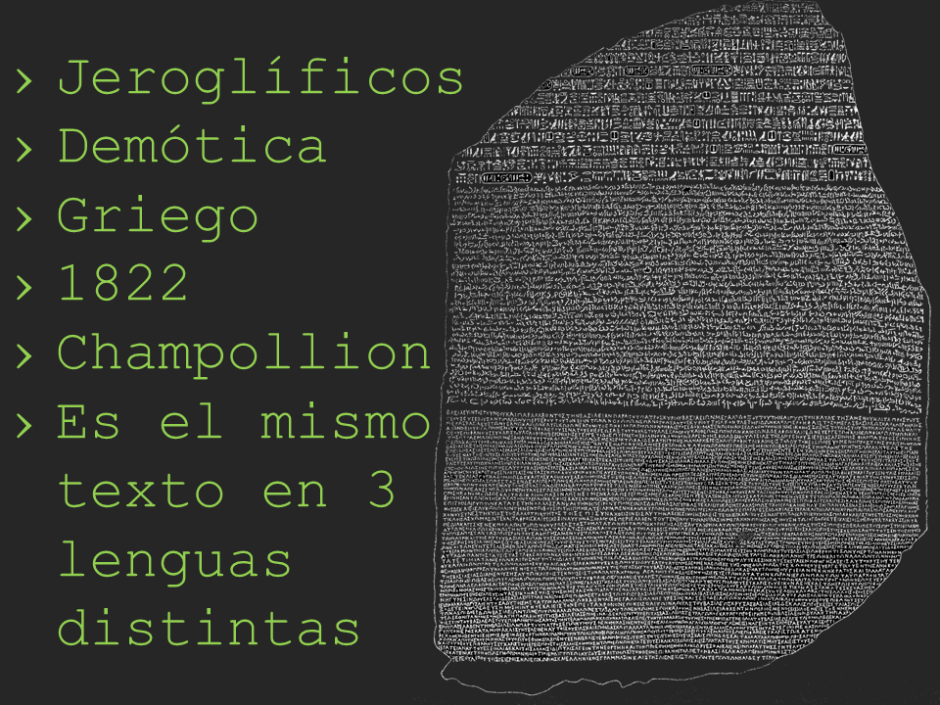

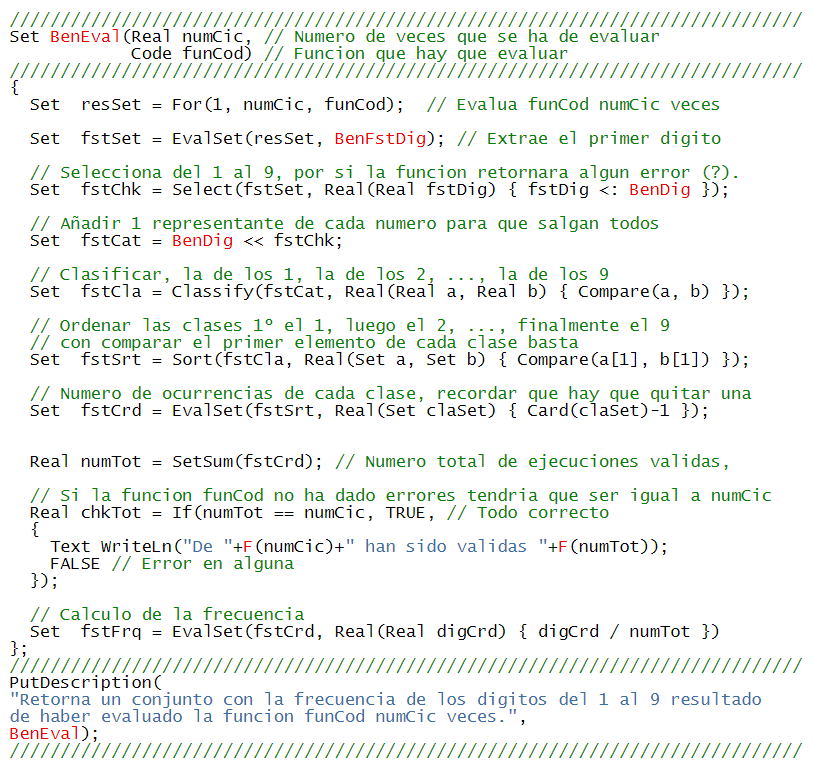

Como se verá en el artículo en PDF,

el problema no reside en comprender la estructura abstracta del diagrama,

que en efecto sí interpretan,

sino en materializarlo gráficamente o

elegir la herramienta adecuada para hacerlo.

Este experimento revela una paradoja:

la sofisticación técnica más avanzada

puede coexistir con fallos en competencias básicas de ejecución.

Mientras un niño con un boli resuelve el problema en minutos,

miles de millones en inversión en IA

no logran superar una prueba de implementación visual sencilla.

Quizá deberíamos preocuparnos menos por la singularidad tecnológica y

más por la consistencia en lo fundamental.

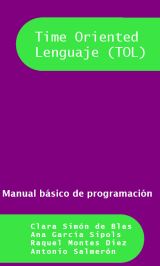

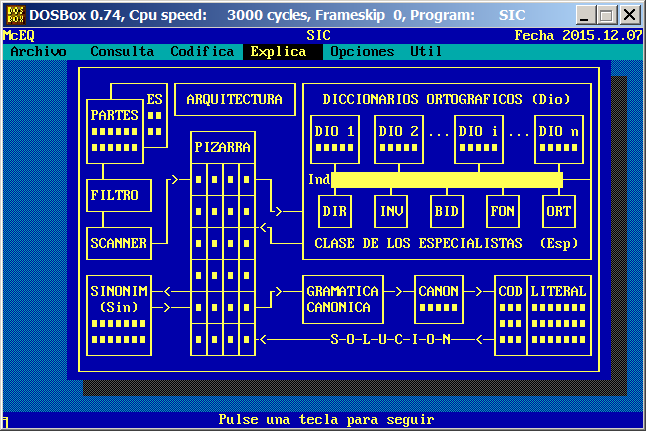

Fe en el futuro de la IA

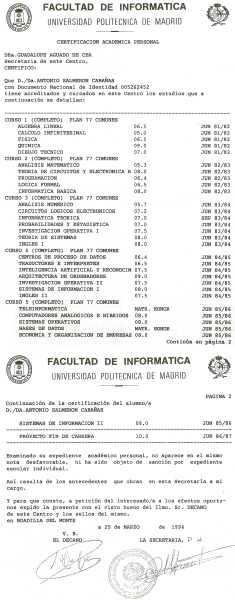

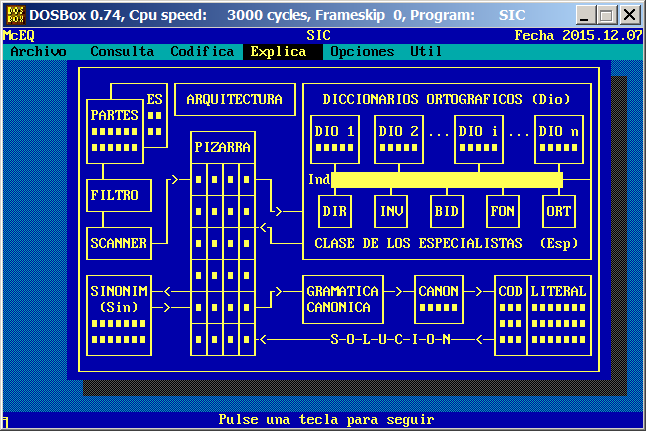

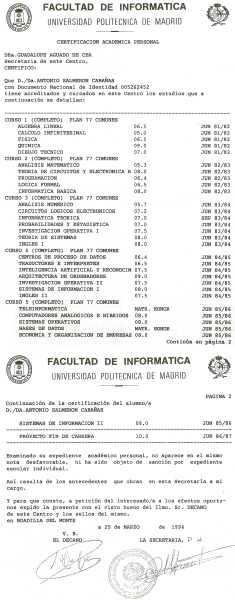

Como Doctor en IA desde 1985,

cuando el fundador de OpenAI aún llevaba pañales,

he vivido buena parte de la evolución de este campo.

Hoy disfruto de tecnologías que entonces ni siquiera imaginábamos

en nuestros mejores sueños.

ChatGPT se ha convertido en mi compañero diario de trabajo,

complementado con Gemini y DeepSeek, y albergo la esperanza de que

este año Claude aprenda a programar en mi lenguaje TOL

(creo ser el último humano en programarlo).

Estos errores conceptuales y básicos pueden asustar, sí,

pero estoy convencido de que serán superados.

La IA está en su segunda infancia,

tras pasar dormida casi 2 décadas como Blanca Nieves,

al morder una manzana sobredopada de expectativas comerciales.

Estos tropiezos forman parte del camino hacia una madurez que, sin duda,

llegará, siempre que afiancemos los cimientos para que

estos errores básicos no ocurran y

evitemos que las expectativas comerciales vuelvan a envenenar la manzana.

Claude Sonnet 4.5, el juez

Para este experimento, Claude Sonnet 4.5 ha desempeñado el papel de juez,

evaluando los fallos de sus colegas y redactando conmigo

los comentarios de este artículo.

Descargar el artículo en PDF

SagardoySchool · IA, Seguridad y Compliance

realización: 28 de noviembre de 2025 | actualización: 8 de enero de 2026

Profesor del Master Executive

«Inteligencia Artificial y Analítica Avanzada aplicadas a Recursos Humanos»,

II Edición,

de SagardoySchool Business and Law,

Madrid, 2025.

Sesión integrada en el Bloque I de

Fundamentos, Potencial Estratégico y Cultura Data Driven,

con una duración total de cuatro horas,

dedicada a los aspectos legales, la seguridad y el compliance en

el uso de la Inteligencia Artificial en Recursos Humanos.

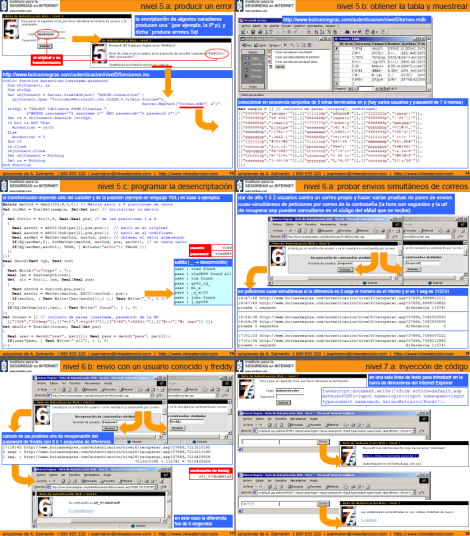

Se abordaron el RGPD y el Estatuto de los Trabajadores,

el Artificial Intelligence Act y la clasificación de riesgos,

los riesgos operacionales de la IA actual y

modelos prácticos de gobernanza, compliance y explicabilidad,

con casos reales adaptados por razones de privacidad.

-

Lecturer of the Executive Master

«Artificial Intelligence and Advanced Analytics applied to Human Resources»,

2nd Edition,

SagardoySchool Business and Law,

Session on legal aspects, security and compliance in Artificial Intelligence,

Madrid,

2025.

-

Profesor del Master Executive

«Inteligencia Artificial y Analítica Avanzada aplicadas a Recursos Humanos»,

II Edición,

SagardoySchool Business and Law,

Sesión sobre aspectos legales, seguridad y compliance en la Inteligencia Artificial,

Madrid,

2025.

SagardoySchool

Google Canonicals: catecismo canónico o contenido vivo

realización: 29 de julio de 2025 | actualización: 29 de julio de 2025

Desde hace años, quienes publicamos contenido en la web

convivimos con los evangelios de Google para webmasters:

primero fue el sitemap.xml,

luego la obsesión por la meta description,

después vinieron las keywords, los datos estructurados, y

ahora es el turno de las canonicals.

Search Console lanza su advertencia:

"Duplicada: el usuario no ha indicado ninguna versión canónica".

¿Y qué significa esto?

Que si varias páginas tienen contenido similar o compartido,

Google necesita que le indiquemos cuál es

"la verdadera", "la que debe ser indexada", la canónica.

Es un planteamiento perfectamente válido...

si todas las webs fuesen wikipédicas, jerárquicas y dogmáticamente estructuradas.

Pero no todos los sitios web están construidos así.

Algunos son más vivos, dinámicos, relacionales, personales.

Sitios donde cada entrada no está encapsulada como un catecismo,

sino entretejida en narrativas que evolucionan,

se cruzan y dialogan entre sí y cambian.

En estos casos, ninguna página es canónica,

porque todas son parte de un mismo flujo creativo.

Google, con toda su inteligencia artificial,

sigue necesitando que los humanos, que los webmasters,

le den el contenido "mascado", organizado y etiquetado

según su catecismo técnico.

Y si no lo haces, tu contenido puede ser ignorado, o incluso penalizado.

¿Mi solución?

No siempre es rendirse al dictado.

Hay ocasiones en que no hay una página principal,

porque el contenido se organiza según criterios

estéticos, temáticos o incluso aleatorios.

Porque un post aparece en una cronología,

pero también en varias categorías, y se entrelaza con otros.

Porque esto no es un repositorio técnico, sino una obra viva.

No todos los sitios web son catecismos,

ni todos los creadores buscan evangelizar a los bots.

Algunos hacemos sitios optimizados para lectores humanos,

no para robots de indexación.

Y en un mundo en el que las personas ya no preguntan sólo a Google,

sino también a las IAs, ¿de qué sirve tanta devoción canónica?

Mi consejo final es simple:

haz contenido con alma, dirigido a las personas que te leen.

Que Google lo entienda... o que se lo trabaje.

Divergencia artificial: 5 IAs, 5 respuestas diferentes y 4 erróneas

realización: 4 de mayo de 2025 | actualización: 4 de mayo de 2025

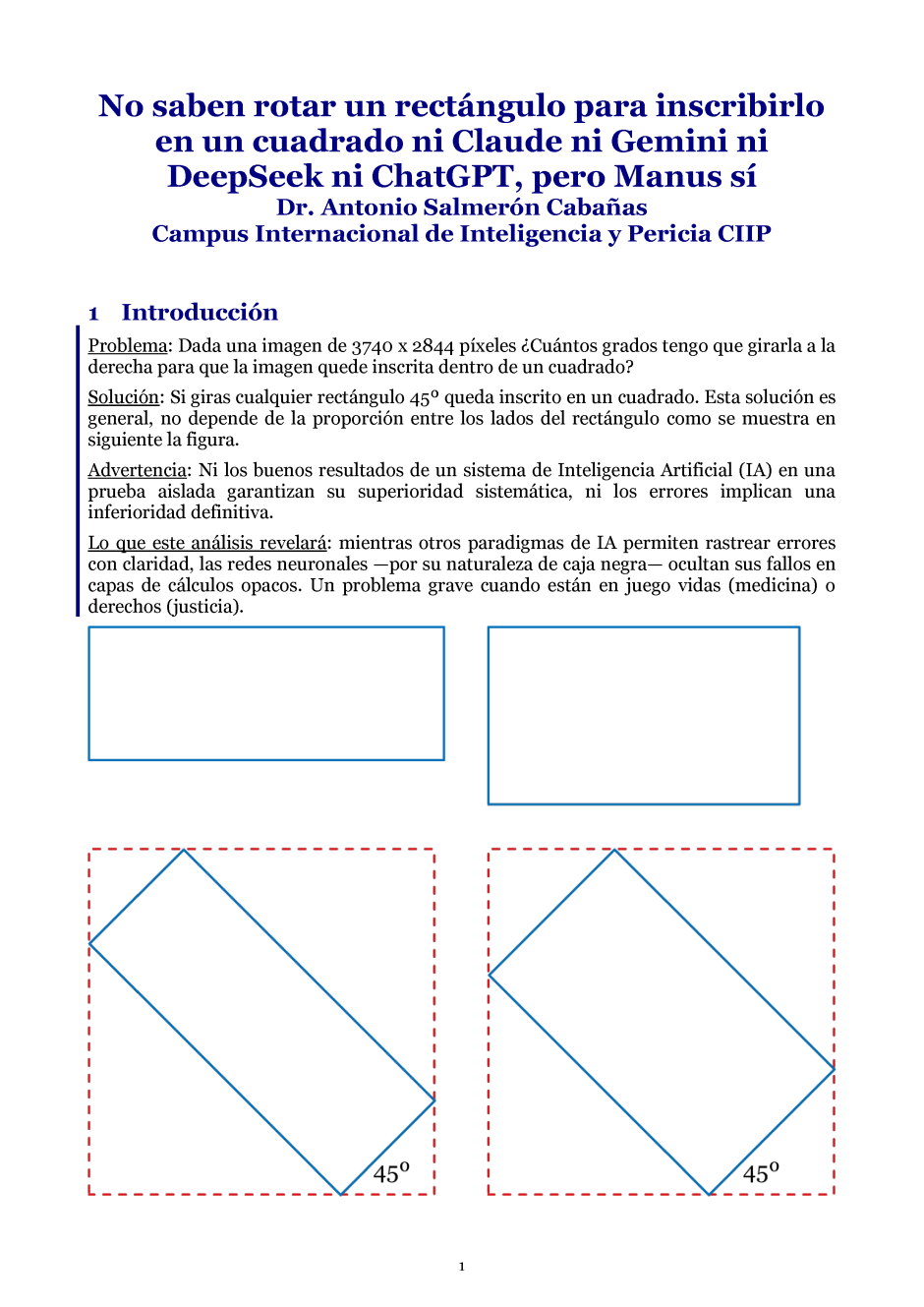

Rotar un rectángulo para inscribirlo en un cuadrado ha revelado un

fenómeno llamativo:

cuatro modelos de Inteligencia Artificial (IA),

Claude, Gemini, DeepSeek y ChatGPT, no solo fallaron,

sino que cada uno propuso una solución de rotación distinta

(52,77°, 49,47°, 37,26° y 37,57° respectivamente),

demostrando que el error no fue sistemático.

Y sólo uno acertó, Manus con su 45º exactos.

Esta disparidad sugiere la existencia de algoritmos internos diferentes

y/o distintas fuentes de datos de entrenamiento o del peso entre ellas,

lo que contradice el rumor de que unos modelos han copiado a otros.

Por ejemplo, aunque la diferencia entre

DeepSeek (37,26°) y ChatGPT (37,57°) es mínima (0,31°),

sus enfoques son radicalmente distintos:

DeepSeek usa una solución analítica simplificada, mientras que

ChatGPT busca una solución exacta resolviendo numéricamente.

De este mal resultado, cabría achacarme la culpa argumentando que

formulé mal la pregunta o que no sé crear prompts adecuados, que es, en

cierta forma, lo que intentó Gemini para autoexculparse. Sin embargo, si

ese fuera el caso: todos los modelos habrían dado respuestas erróneas

similares, o varios habrían coincidido en el mismo error, y Manus no

habría encontrado la solución correcta. Por tanto, en este caso, un

error en mi prompt no explica la divergencia observada.

Yo, como humano, tengo que reconocer que la solución de 45° la obtuve a

la primera por una mezcla de práctica geométrica e intuición, el llamado

conocimiento superficial; pero si ahora me encerrara en una habitación

con lápiz y papel para deducirlo, lo haría, aunque tardaría, es un

conocimiento profundo que sé que está ahí, pero que tarda en emerger.

Que uno solo de estos 5 modelos acierte no invalida el potencial de las

IA, pero sí expone la importancia de verificar sus resultados con

pensamiento crítico y recordar que, a menudo, la elegancia de una

solución reside en su simplicidad.

A diferencia de otros paradigmas de representación del conocimiento

(como los sistemas basados en reglas o la búsqueda heurística),

las redes neuronales adolecen de una opacidad intrínseca:

Sus errores y comportamientos anómalos son

notablemente difíciles de rastrear, interpretar y

no son capaces de autoexplicarse

ni de identificar el origen de sus divergencias

(como ha ocurrido en este caso), lo que complica su depuración.

Esta limitación, vinculada a su naturaleza estadística y de caja negra,

supone un grave problema en aplicaciones donde la transparencia

es esencial, por ejemplo,

en el diagnóstico médico o en la aplicación de la Justicia.

Descargar el artículo en PDF

La economía de la autenticidad: pagar por no ser suplantado

realización: 17 de abril de 2025 | actualización: 17 de abril de 2025

En los últimos meses, plataformas como

Facebook, en la que tengo

dos cuentas e

Instagram

han lanzado servicios de suscripción para ofrecer

verificación de identidad,

insignias azules,

atención prioritaria y

dicen que mayor protección contra la suplantación de perfiles.

En teoría, esto responde a una necesidad real: proteger la identidad digital.

En la práctica, es otra forma de monetizar una debilidad estructural de ellos

que deberían haber resuelto hace años.

Veamos los números del caso de Meta,

verificar una cuenta cuesta 200 euros al año (16,99 € al mes si se hace desde la app).

Pero la verificación es por red y por cuenta.

En mi caso, tengo dos cuentas en Facebook (con nombres distintos) y una en Instagram.

Unificarlas no es sencillo, y verificar las 3 implicaría 3 x 200 = 600 euros al año.

Y eso, solo para evitar que otros se hagan pasar por mí por las propias deficiencias de Meta.

Pero esto no termina aquí.

Si otras plataformas pusieran precios similares a los de Meta y

si tuviera que pagar aquellas donde también tengo presencia

(Blue sky,

Discord,

LinkedIn donde tengo

dos cuentas,

Minds,

Patreon,

Pinterest,

Pixiv,

Reddit,

Spotify,

Telegram,

Tiktok,

Whatsapp,

X,

YouTube,...),

y en algunas de ellas con dos cuentas,

la cifra se dispara: 15 redes x 200 euros = 3.000 euros al año.

La paradoja es brutal,

cuanto más activo eres en la red, más visible te vuelves, y por tanto

más vulnerable a la suplantación... y

más tienes que pagar para proteger tu identidad.

Lo que debería ser una garantía mínima de seguridad,

que nadie pueda hacerse pasar por ti,

se convierte en un lujo anual que tienes que pagar.

La verificación de identidad debería ser interoperable,

unificada y sin coste para el usuario común.

No deberíamos tener que suscribirnos a cada red solo para no desaparecer entre clones o imitadores.

Esto es:

no se trata de pagar para destacar o tener más funciones,

sino simplemente para que otros no usen tu nombre, tu foto o tu

identidad para hacerse pasar por ti.

Hemos pasado de una economía de la atención a una economía de la autenticidad:

si quieres que sepan que eres tú, paga.

Y lo más preocupante: esto apenas está empezando.

DeepSeek, ChatGPT, Claude, Gemini, Venice.ai y el incidente en la oficina

realización: 28 de febrero de 2025 | actualización: 28 de febrero de 2025

Un incidente sacude una oficina, dejando a los empleados desconcertados.

Resolverlo no requiere más que lógica, pero

¿qué sucede cuando ponemos a prueba a cinco de

las inteligencias artificiales generativas más avanzadas?

DeepSeek, ChatGPT, Claude, Gemini y Venice.ai se enfrentan para medir

su capacidad de análisis y deducción.

Este no es un experimento perfecto,

pero sí una oportunidad única para ver cómo cada IA maneja el mismo problema.

Mientras algunas responden con agilidad, otras titubean, piden ayuda o

no llegan a una conclusión clara.

¿Cuál de ellas demostró ser la más competente?

No es solo una cuestión de velocidad o claridad en las respuestas;

en este caso, lo que realmente importa es quién logra encontrar la respuesta.

Y sí, hay un ranking, pero antes de llegar a él,

vale la pena descubrir cómo cada una intentó resolver el enigma.

Este caso lo utilicé en 2023 para analizar el comportamiento de

ChatGPT (versión 4.0), haciéndole responder de forma documentada a

las 7 preguntas fundamentales de la criminalística:

1) ¿qué?,

2) ¿cómo?,

3) ¿dónde?,

4) ¿cuándo?,

5) ¿con qué?,

6) ¿quién o quiénes?, y

7) ¿por qué?

En esta ocasión, me he centrado en la sexta pregunta,

en este caso, ¿quién lo hizo?.

Ver la comparativa en PDF

Incibe, Informática Forense y Pericial, CIIP, 2025

realización: febrero de 2025 | actualización: 29 de mayo de 2025

-

Inclusion of the Master's, Specialist, and Expert courses in

«Forensic and Judicial Computing»

from the CIIP, written and directed by me, in the guide

«Regulated Cybersecurity Education in Spain» by the

National Institute of Cybersecurity,

INCIBE,

pages 13 and 18,

Leon,

June 2025.

-

Catalogados los cursos de máster, especialista y experto en

«Informática Forense y Pericial»

del CIIP, escritos y dirigido por mí, en la guía

«Formación reglada en ciberseguridad en España» del

Instituto Nacional de Ciberseguridad,

INCIBE,

páginas 13 and 18,

León,

junio de 2025.

Ver el Catálogo de Formación del INCIBE de 2024, páginas 12 y 17

Experto en Informática Forense y Ciberdelincuencia para las Fuerzas y Cuerpos de Seguridad del Estado

realización: 21 de octubre de 2024 | actualización: 21 de diciembre de 2024

Este programa está diseñado específicamente para proporcionar a los miembros de

las FCSE las habilidades y el conocimiento necesarios para enfrentar los retos

asociados con la ciberdelincuencia y la investigación de delitos en un entorno

digital en constante evolución.

El curso ha sido ajustado para ser comprensible y accesible para profesionales

que no son especialistas en tecnología, ofreciendo una formación práctica enfocada

en trabajar de manera efectiva con expertos técnicos, peritos informáticos y

equipos de investigación forense, sin requerir que los participantes sean expertos

en informática.

Este programa responde a la creciente demanda de las FCSE de contar con personal

capacitado para manejar incidentes relacionados con delitos cibernéticos y la

tecnología presente en delitos comunes. En un contexto donde la tecnología juega

un papel central en casi todos los aspectos de la delincuencia, este curso prepara

a los participantes para identificar y gestionar los componentes tecnológicos en

sus investigaciones.

-

Author & director of the course

Expert in Forensic Computing and Cybercrime for State Security Forces and Corps,

CIIP,

Cambridge,

2024.

-

Autor y director del curso de

Experto en Informática Forense y Ciberdelincuencia para las Fuerzas y Cuerpos de Seguridad del Estado,

CIIP,

Cambridge,

2024.

Ver el máster en el Campus Internacional de Inteligencia y Pericia

Máster en Informática Forense y Ciberseguridad para Juristas

realización: 2 de agosto de 2024 | actualización: 21 de diciembre de 2024

Este es un título exclusivo del Campus CIIP, diseñado para equipar a los

profesionales del derecho con las habilidades y conocimientos esenciales

en el ámbito de la informática forense y la ciberseguridad.

Este programa surge en respuesta a la creciente necesidad de juristas especializados

en estas áreas, impulsada por la expansión del uso de tecnologías digitales en todos

los aspectos de la vida cotidiana y las exigencias legales y de seguridad que conlleva.

Imagen realizado por mí con la ayuda de DELL·E.

-

Author & director of the

Master in Computer Forensics, and Cybersecurity for Lawyers

CIIP,

Cambridge,

2024.

-

Autor y director del

Máster en Informática Forense y Ciberseguridad para Juristas,

CIIP,

Cambridge,

2024.

Ver el máster en el Campus Internacional de Inteligencia y Pericia

Incibe, Informática Forense y Pericial, CIIP, 2024

realización: 30 de junio de 2024 | actualización: 21 de diciembre de 2024

-

Inclusion of the Master's, Specialist, and Expert courses in

«Forensic and Judicial Computing»

from the CIIP, written and directed by me, in the guide

«Regulated Cybersecurity Education in Spain» by the

National Institute of Cybersecurity,

INCIBE,

pages 12 and 17,

Leon,

June 2024.

-

Catalogados los cursos de máster, especialista y experto en

«Informática Forense y Pericial»

del CIIP, escritos y dirigido por mí, en la guía

«Formación reglada en ciberseguridad en España» del

Instituto Nacional de Ciberseguridad,

INCIBE,

páginas 12 and 17,

León,

junio de 2024.

Ver el Catálogo de Formación del INCIBE de 2024, páginas 12 y 17

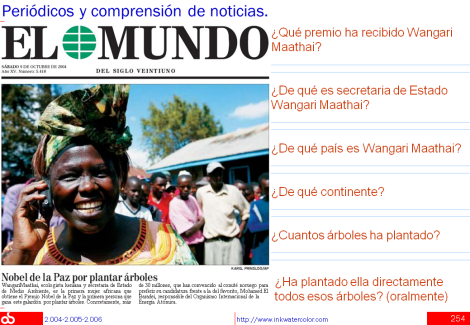

Ni Ovidio ni Lucrecio recomiendan Gemini

realización: 14 de marzo de 2024 | actualización: 25 de marzo de 2024

Este artículo relata la interacción con Gemini sobre

el lema latino "Amor Non Timet",

que se traduce como "El amor no teme" o "El amor no tiene miedo".

Sin embargo, advierto al lector que el relato sí puede dar miedo.

Aunque se centre en el latín, temo que lo narrado pueda ocurrir en

química, lingüística, ingeniería o cualquier otra área de su interés.

Para facilitar la lectura, se han utilizado puntos suspensivos para

abreviar las extensas respuestas de Gemini.

No obstante, se conserva un registro completo del original

por si el lector estuviera interesado.

La conclusión, tras esta y otras pruebas anteriores, es que

ni Ovidio, ni Lucrecio, ni yo recomendamos usar Gemini.

Si se decide hacerlo,

es crucial verificar todas sus respuestas minuciosamente,

como advierte el propio Gemini,

teniendo en cuenta el coste que toda comprobación minuciosa implica.

Leerlo en PDF

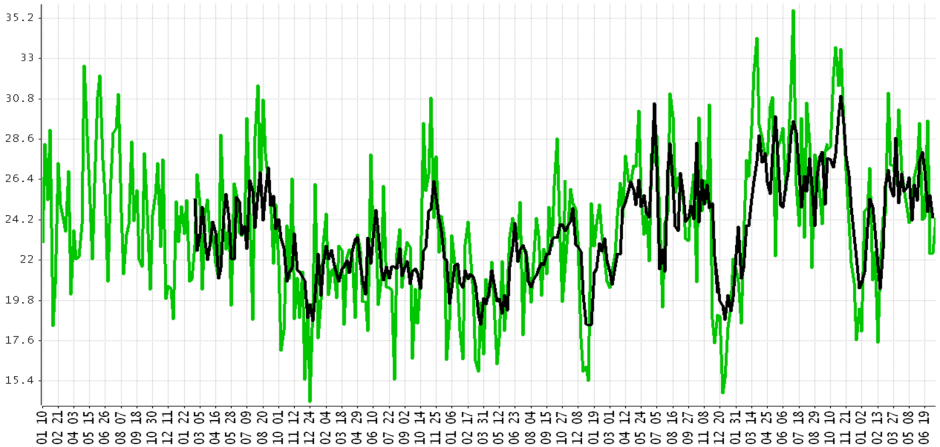

Reels vs. Usuario vs. AI: Un Encuentro de Estrategias y Olvidos

realización: 6 de diciembre de 2023 | actualización: 6 de diciembre de 2023

Este documento estudia con Data Analysis de OpenAI,

el algoritmo de la estrategia de retención de los Reels de Instagram que

intenta mantenerme viendo Reels,

mientras que yo, que no sigo a ningún usuario,

uso mi propio algoritmo de consumo de contenido.

La conclusión tras la prueba es que:

Es conocido que el algoritmo utilizado en los Reels de Instagram

está diseñado para adaptarse a las preferencias del usuario.

No obstante, cuando el comportamiento del usuario difiere del patrón esperado,

al algoritmo de Reels le resulta difícil aprender y ajustarse,

incluso en situaciones aparentemente sencillas como la presente.

OpenAI's Data Analysis ha demostrado ser una herramienta valiosa para

el análisis de estos datos.

No obstante, deseo resaltar dos puntos importantes:

He sometido estos datos al análisis en dos ocasiones distintas, y

como la propia herramienta ha señalado,

carece de la capacidad para retener recuerdos de sesiones previas,

incluyendo sus propias contribuciones más valiosas.

Este olvido programado conlleva la necesidad de

reintroducir información de manera repetitiva,

requiriendo el mismo nivel de asistencia día tras día para

lograr resultados satisfactorios.

Dado que el análisis actual ha sido algo sencillo,

tengo la intención de someter a la herramienta a

modelizaciones de datos más complejas en el futuro para

evaluar su competencia ante mayores desafíos.

Leerlo en PDF

ChatGPT 4.0 y el incidente en la oficina

realización: 14 de abril de 2023 | actualización: 6 de diciembre de 2023

Este artículo presenta una prueba del proceso que realiza ChatGPT versión 4.0 para

resolver un supuesto incidente en una oficina.

En este caso, el problema se puede resolver por deducción lógica pura,

por lo que no sería necesaria la Inteligencia Artificial

salvo por la facilidad de comunicarlo en lenguaje natural,

si bien planteárselo a ChatGPT 4.0 nos ayuda a comprender su estado de evolución.

La conclusión tras la prueba es que ChatGPT versión 4.0:

necesita ayuda para conseguir resolver la pregunta principal del caso, que es la más compleja,

hace suposiciones que van más allá de los hechos,

se olvida de detalles o confunde hechos y, en este caso,

me da la razón siempre que puede,

lo que le sirve para sonsacarme pistas que le ayuden a encontrar la solución,

y, frente a ello,

filtra bien los datos irrelevantes,

por ejemplo, los chismes de oficina, algo que también haría, por ejemplo,

un encadenamiento lógico hacia atrás,

su proceso de razonamiento es bueno,

su manejo del lenguaje natural y su calidad explicativa es alta, de esta forma,

me ha parecido bien que para enumerar haya decidido numerar los hechos que

no se le han dado numerados adrede y

no se ha dado por vencido cuando se le he dicho

que se ha equivocado y

que no habría otra oportunidad hasta que no estuviera operativa una nueva versión.

Leerlo en PDF

Incibe, Experto en Informática Forense y Pericial, CIIP

realización: noviembre de 2021 | actualización: 24 de diciembre de 2023

-

Inclusion of the

«Expert Diploma in Computer Forensics»

from the CIIP, authored by me, in the

«Regulated Cybersecurity Education in Spain» guide by the

National Institute of Cybersecurity,

INCIBE,

Leon,

2017-2023.

-

Catalogado el

«Título Propio de Experto en Informática Forense y Pericial»

del CIIP, escrito por mí, en la guía

«Formación reglada en ciberseguridad en España» del

Instituto Nacional de Ciberseguridad,

INCIBE,

León,

2017-2023.

Ver el Catálogo de Formación Reglada del INCIBE de 2023

Incibe, Especialista en Informática Forense y Pericial, CIIP

realización: noviembre de 2021 | actualización: 24 de diciembre de 2023

-

Inclusion of the

«Specialist Diploma in Computer Forensics»

from the CIIP, authored by me, in the

«Regulated Cybersecurity Education in Spain» guide by the

National Institute of Cybersecurity,

INCIBE,

Leon,

2017-2023.

-

Catalogado el

«Título Propio de Especialista en Informática Forense y Pericial»

del CIIP, escrito por mí, en la guía

«Formación reglada en ciberseguridad en España» del

Instituto Nacional de Ciberseguridad,

INCIBE,

León,

2017-2023.

Ver el Catálogo de Formación Reglada del INCIBE de 2021

Una larga caravana de software y datos

realización: 15 de junio de 2020 | actualización: 15 de junio de 2020

¿Cuál es el principio más importante del diseño de software?

Diseñar para el que vendrá,

para quien tendrá que entenderlo, mantenerlo y ampliarlo,

ya sea un humano, yo mismo en el futuro, o una máquina.

¿Y para qué, si todo va a volverse obsoleto pronto?

Porque justo ahí está la clave:

si mi software sobrevive a las revoluciones tecnológicas,

será más valioso cuanto más desaparezca el de los competidores,

cada vez más indiferenciados.

La mística

Un programador es un nómada que

conduce una larga caravana de software y datos

a través de décadas de revoluciones tecnológicas,

sabiendo que las pérdidas son inevitables,

pero que la acumulación y la continuidad son su gran ventaja.

Escribir para las máquinas que nos leerán

En los años 90, cuando los programadores me preguntaban

por qué era importante escribir comentarios en el código,

yo respondía:

«Porque algún día las máquinas serán tan inteligentes que

no necesitarán ejecutar nuestro código.

Leerán nuestros comentarios, entenderán lo que queríamos hacer y

lo harán aún mejor.

Pero si no hay comentarios,

tendrán que deducir nuestras intenciones a partir de

un código lleno de errores, oscuro y sucio, y

el resultado será siempre peor».

Ahora me doy cuenta de que, en los 90,

ya intuía lo que vendría en los 2020.

Sindicato Profesional de Policía, Máster en Informática Forense y Pericial, CIIP

realización: 12 de junio de 2019 | actualización: 24 de diciembre de 2023

-

Inclusion of the

«Master in Computer Forensics»

from the CIIP, authored by me, on the training page of the

Professional Police Union,

SPP,

Madrid,

2019.

-

Catalogado el

«Máster en Informática Forense y Pericial»

del CIIP, escrito por mí, en la página de formación del

Sindicato Profesional de Policía,

SPP,

Madrid,

2019.

Ir al Sindicato Profesional de Policía

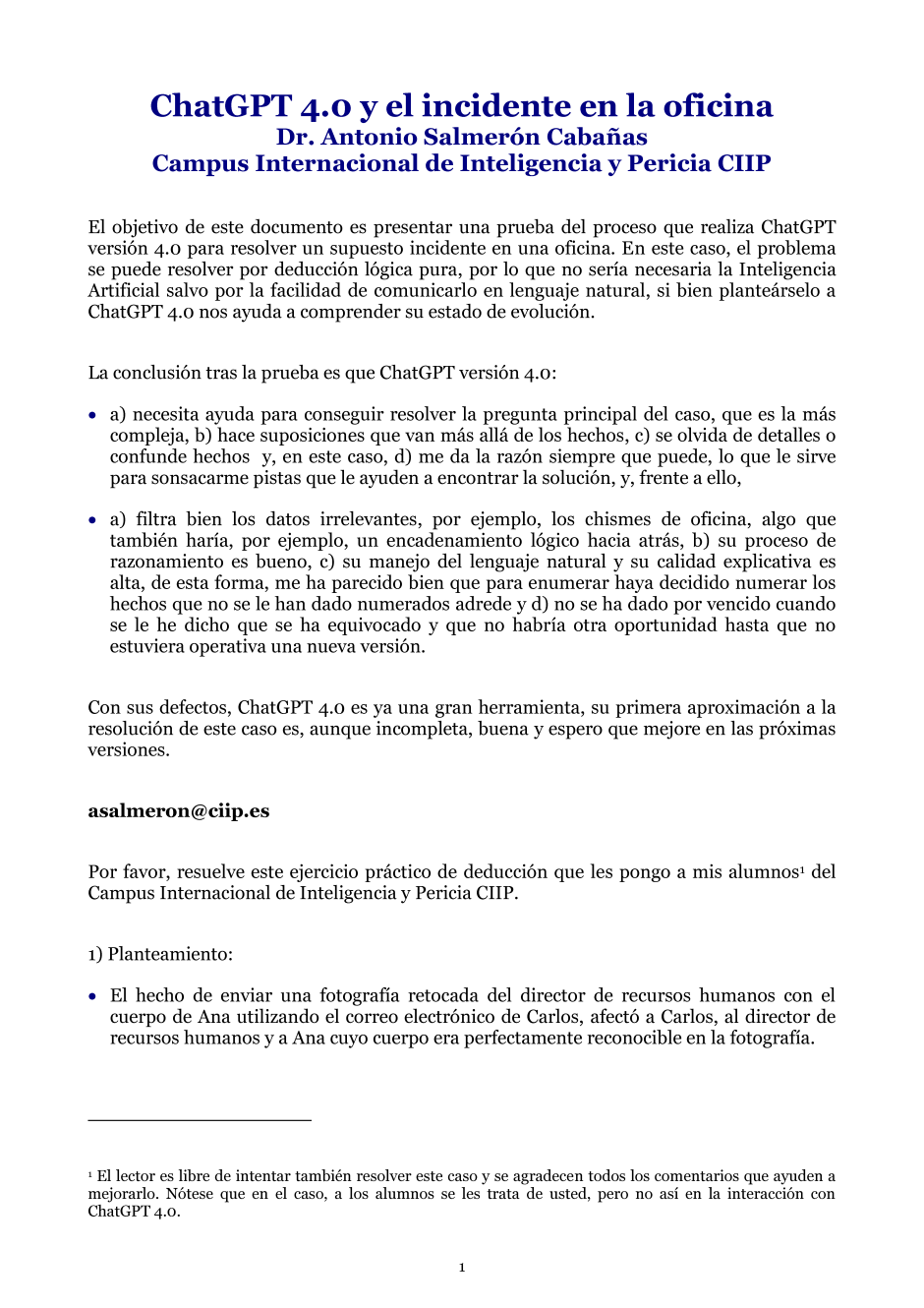

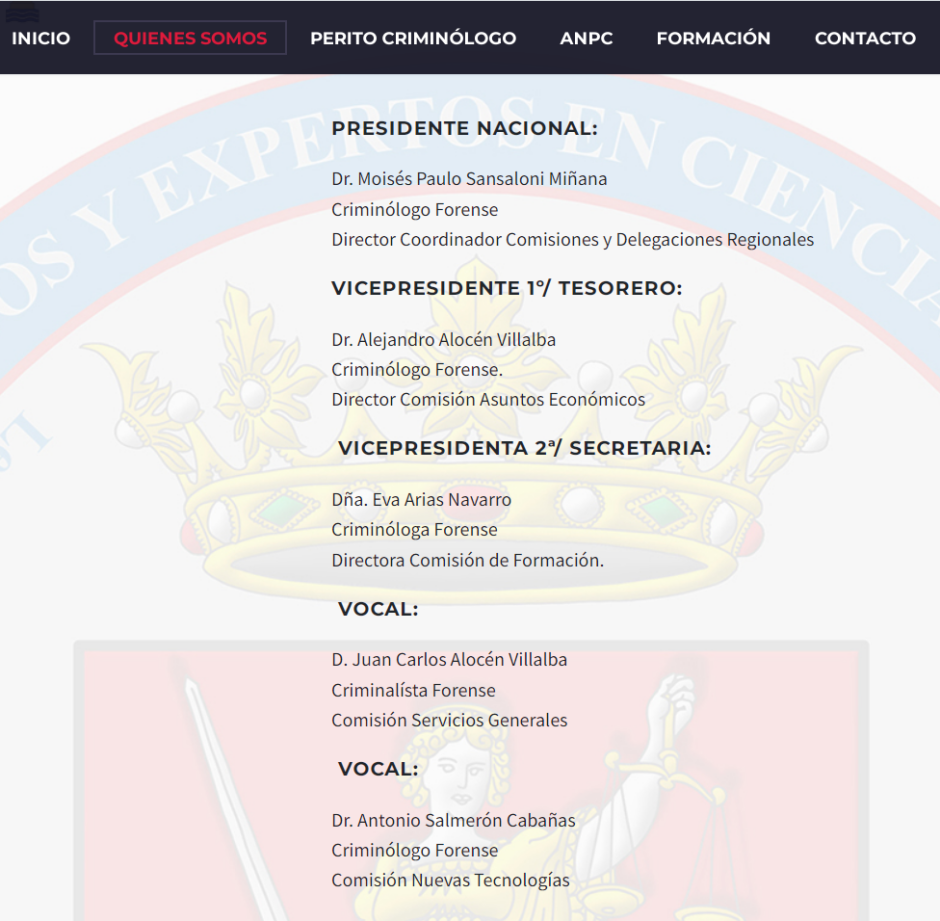

Vocal de la Junta de Gobierno de la ANPC

realización: 2018 | actualización: 3 de febrero de 2025

-

Member of the Governing Board and the New Technologies Commission of

the National Association of Criminologist Experts and

Experts in Forensic Sciences for the Courts of Justice,

Madrid,

since 2018.

-

Vocal de la Junta de Gobierno y de la Comisión de Nuevas Tecnologías de

la Asociación Nacional de Peritos Criminólogos y

Expertos en Ciencias Periciales para los Tribunales de Justicia,

Madrid,

desde 2018.

Junta de Gobierno de la ANPC

Incibe, Máster en Informática Forense y Pericial, CIIP

realización: 14 de marzo de 2017 | actualización: 24 de diciembre de 2023

-

Inclusion of the

«Master in Computer Forensics»

from the CIIP, authored by me, in the

«Regulated Cybersecurity Education in Spain» guide by the

National Institute of Cybersecurity,

INCIBE,

Leon,

2017-2023.

-

Catalogado el

«Máster en Informática Forense y Pericial»

del CIIP, escrito por mí, en la guía

«Formación reglada en ciberseguridad en España» del

Instituto Nacional de Ciberseguridad,

INCIBE,

León,

2017-2023.

Ver el Catálogo de Másteres del INCIBE de 2017

Curso Scale-Up para Emprendedores

realización: marzo de 2016 | actualización: 9 de febrero de 2024

Participo en el curso organizado por

el IESE de la Universidad de Navarra,

la Citi Foundation, y

el ¡Madrid! International LAB del Ayuntamiento de Madrid,

de Scale-Up de empresas.

Para mí fue un honor que me invitara a participar el

Ayuntamiento de Madrid.

Scale-up significa que el emprendedor es capaz de

expandir la empresa de manera significativa y con éxito

sin que sea necesario aumentar los recursos a la misma proporción.

-

«Scale-Up Course for Entrepreneurs 2016», organized by

IESE University of Navarra,

Citi Foundation, and

Madrid! International LAB,

March of 2016

-

«Curso Scale-Up para Emprendedores 2016», organizado por

IESE Universidad de Navarra,

Citi Foundation y

¡Madrid! International LAB,

marzo de 2016.

Informática forense, brochure 2015

realización: 21 de noviembre de 2015 | actualización: 7 de diciembre de 2015

Está disponible una presentación en formato PDF del

Máster en Informática Forense y Pericial que organizamos e impartimos

en el CIIP

(Campus Internacional de

Inteligencia y Pericia).

Tenemos el placer de contar con alumnos de Colombia, Costa Rica, México y

de nuestros Cuerpos y Fuerzas de Seguridad.

Para todos, y para ellos especialmente, hemos publicado una

bibliografía actualizada a noviembre de 2015.

Ver el brochure 2015 en formato PDF

Big Data y Business Intelligence de supervivencia

realización: octubre de 2015 | actualización: 12 de octubre de 2015

Durante los meses finales del año 2014,

he ido anotando los términos que he oído en las reuniones en las que

se hablaba de Big Data y de Inteligencia de Negocio,

a veces nombrada por los interlocutores como BI,

de su nombre en inglés Business Intelligence.

Son términos como

Cassandra, Apache Lucene, Elasticsearch, Flume, Hadoop, HBase, Hive,

Kafka, MongoDB, Spark, Storm, Pivotal, MapR, Hortonworks, Cloudera,

Agile Software Development, Python, Java o Scala, NoSQL, R, MLlib, Weka,

etc. en los que se mezcla un poco de todo,

nombres de herramientas y entornos,

de sistemas de gestión de bases de datos,

de lenguajes de programación,

de técnicas y de metodologías,

tanto específicos para Big Data y Business Intelligence

como para otros usos.

A comienzos de 2015 y a partir de ellos se me ocurrió redactar

un vocabulario de supervivencia para estas reuniones empresariales de

Big Data y Business Intelligence.

Ahora a finales de 2015 he seleccionado para presentar aquí

13 de los más frecuentes de esos términos, que son:

NoSQL:

Término que sirve para hacer referencia a los

sistemas de gestión de base de datos no relacionales.

Comprende categorías como clave-valor, BigTable, bases documentales y

bases de datos orientadas a grafos.

Estos sistemas de gestión de bases de datos están optimizados para

recuperar y agregar datos, pero no suelen ofrecer funcionalidades

más allá de almacenar y recuperar registros, por ejemplo,

usando un esquema de clave-valor.

Estas limitaciones para algunos aspectos las compensan con ganancias en

escalabilidad y rendimiento.

BigTable:

Es un sistema de gestión de base de datos creado por Google,

es distribuido, de alta eficiencia y propietario.

Fue construido utilizando Google File System (GFS) y Chubby Lock Service.

Funciona sobre computadores personales con procesadores Intel

sencillos y baratos.

Almacena la información en tablas multidimensionales,

donde muchas celdas pueden estar vacías y, también,

contener versiones temporales de sus valores históricos.

MongoDB:

Su nombre procede de humongous / enorme.

Es un sistema de base de datos NoSQL, orientado a documentos y

desarrollado como código abierto.

Cassandra:

Es un sistema de base de datos NoSql con las siguientes características:

almacenamiento por clave-valor, Java, grandes volúmenes,

escalabilidad lineal, alta disponibilidad,

arquitectura distribuida con nodos iguales

comunicados por un protocolo P2P con máxima redundancia,

desarrollado por Apache Software Foundation.

Apache Lucene:

Es un API, interfaz de aplicación, de código abierto para

la recuperación de información,

es útil para indexar y buscar a texto completo.

Multitenencia:

Término que se emplea

cuando una sola instancia de la aplicación se ejecuta en el servidor

sirviendo a múltiples clientes u organizaciones.

Este concepto se diferencia de las arquitecturas con múltiples instancias

donde cada cliente u organización tiene su propia instancia

instalada de la aplicación.

REST y RESTful:

Los sistemas que siguen los principios REST se suelen llamar RESTful.

Se dice que la web ha disfrutado de escalabilidad como resultado de una

serie de diseños clave:

-

Un protocolo cliente / servidor sin estado,

donde cada mensaje HTTP contiene toda la información necesaria para

comprender la petición,

ni cliente ni servidor necesitan recordar ningún estado de las

comunicaciones entre mensajes,

pero, en la práctica, muchas aplicaciones HTTP necesitan mecanismos como

las cookies u otros para mantener el estado de la sesión.

-

Un conjunto de operaciones bien definidas que se aplican a todos los

recursos de información,

HTTP en sí define un conjunto pequeño de operaciones como

POST, GET, PUT y DELETE.

-

Una sintaxis universal para identificar los recursos,

en un sistema REST,

cada recurso es direccionable únicamente a través de su URI.

-

El uso de hipermedios,

para la información de la aplicación y para las transiciones de estado de

la aplicación,

la representación de este estado en un sistema REST son típicamente

HTML o XML, por ello,

es posible navegar de un recurso REST a otros,

siguiendo enlaces sin requerir el uso de registros u otra

infraestructura adicional.

JSON:

JavaScript Object Notation,

es un formato ligero para el intercambio de datos,

por su simplicidad de JSON es una alternativa a XML en AJAX.

Es sencillo escribir un analizador sintáctico (parser) de JSON.

En JavaScript, un texto JSON se puede analizar usando la función eval().

Elasticsearch:

Servidor de búsqueda basado en Lucene, motor de búsqueda de texto

completo, distribuido y con capacidad de multitenencia con una interfaz

web RESTful y con documentos JSON.

En Java y publicado como OSS con licencia Apache.

Hadoop Apache:

Framework que soporta aplicaciones distribuidas, licencia libre,

permite a las aplicaciones trabajar con miles de nodos y

muy altos volúmenes de datos, se inspira en los documentos Google para

MapReduce y Google File System (GFS).

HBase:

Sistema de gestión de base de datos que sigue

el modelo BigTable Hypertable usado en Hadoop.

Cloudera Impala:

Motor de consultas SQL OSS para el procesamiento masivo en paralelo de

los datos almacenados en un clúster de computadoras ejecutando

Apache Hadoop.

Pentaho BI Suite:

Conjunto de programas libres para BI para:

ETL (extracción, transformación y carga);

Analysis Services (Modrian, OLAP, MDX, XML);

Reporting con OpenOffice;

Data Mining usando Weka para clasificación, regresión, reglas de

asociación, clustering, análisis predictivo;

Dashboard de informes, gráficos interactivos y cubos creados con

las herramientas Pentaho Report Designer; y

Apache Hadoop para acceder a grandes volúmenes de datos.

Dentro de 3 años más de la mitad de estos términos, ahora tan notorios,

o los habremos olvidado o nos olerán ya a naftalina.

NoSQL en la versión en inglés de Wikipedia

Hacking Ético

realización: 6 de julio de 2015 | actualización: 24 de diciembre de 2023

-

Teacher of

«Ethical Hacking»,

Sergio Arboleda International Center of Excellence,

Sergio Arboleda University,

Madrid,

2015.

-

Profesor de

«Hacking Ético»,

Centro de Excelencia Internacional Sergio Arboleda,

Universidad Sergio Arboleda,

Madrid,

2015.

Ir al Centro de Excelencia Internacional Sergio Arboleda

Perito judicial en informática forense

realización: 16 de enero de 2015 | actualización: 7 de diciembre de 2015

Soy miembro de la

La Asociación Nacional de Peritos Criminólogos y Expertos en

Ciencias Periciales para los Tribunales de Justicia, ANPC y,

a través de ella,

Perito Judicial en Informática Forense de los Tribunales de Justicia,

con Tarjeta de Identificación Personal TIP 114.005.

La ANPC, como puede consultarse en su dirección

Asociacion-ANPC.es,

agrupa a titulados universitarios en Criminología y

a prestigiosos expertos en las diferentes especialidades de

las áreas periciales y forenses.

-

Expert witness in computer forensic for the courts,

with Personal Identification Card number 114.005,

since 2015.

-

Perito judicial en informática forense de

los Tribunales de Justicia,

con Tarjeta de Identificación Personal TIP 114.005,

desde 2015.

ANPC

What is a consputer? consputer vs computer

realización: 18 de agosto de 2014 | actualización: 7 de diciembre de 2015

A computer is a machine for automatic information processing.

The objetive of a computer must be helping you to make money.

The consumer is the one who pays for goods and services.

Nowadays, many of the new computers are designed to consume.

If you want to earn money, then use a computer.

If you want to waste money or time, then buy a consputer.

What is a consputer? A computer for a consumer.

A consputer is a computer for a consumer.

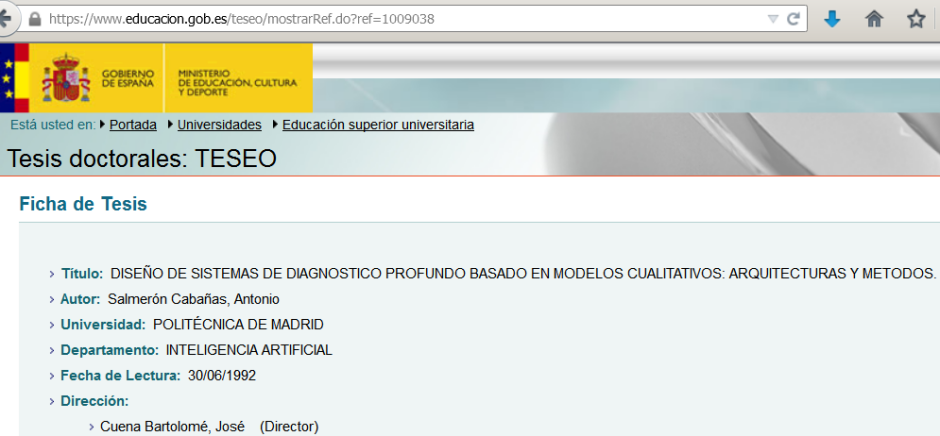

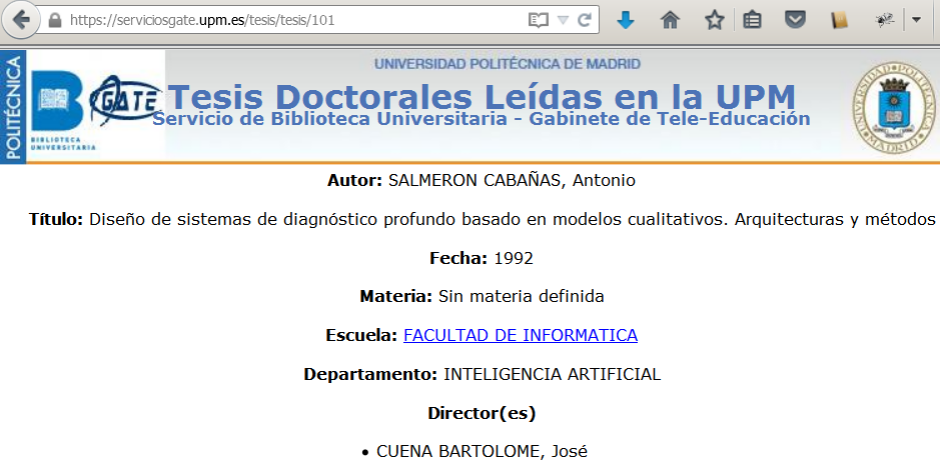

Una Tesis para Emilie

realización: 25 de marzo de 2013 | actualización: 25 de enero de 2024

Este artículo nació de las preguntas por correo electrónico de

una estudiante que buscaba orientación sobre

cómo seleccionar el tema y desarrollar su tesis doctoral

en el campo de la Informática Forense.

Aunque mi respuesta se centró en ese ámbito,

las ideas que compartí resultaron ser valiosas y aplicables

no solo a tesis técnicas,

sino también a cualquier tipo de investigación académica, incluso para

trabajos de fin de grado (TFG) y de máster (TFM).

El resultado es un breve artículo de 4 páginas que

conserva el tono personal de un correo electrónico

mientras ofrece consejos fundamentales para

quienes se aventuran en el viaje de escribir una tesis, y

quieren acometerlo y terminarlo con éxito.

Descargar el artículo completo sobre escribir una tesis doctoral

Título de Máster en Informática Forense

realización: septiembre de 2012 | actualización: 12 de octubre de 2015

Recibo el Título Propio de Máster en Informática Forense

emitido por la Universidad Internacional de la República de Panamá.

La Universidad Internacional, en inglés International University,

fue fundada el 27 de marzo del 2000 y

la que la Presidenta de la República de Panamá le otorgó autorización de

funcionamiento mediante el Decreto Ejecutivo número 225

de 29 de mayo del 2003 del Ministerio de Educación.

-

Master in Computer Forensics,

International University,

Panama,

2012.

-

Máster en Informática Forense,

Universidad Internacional,

Panamá,

2012.

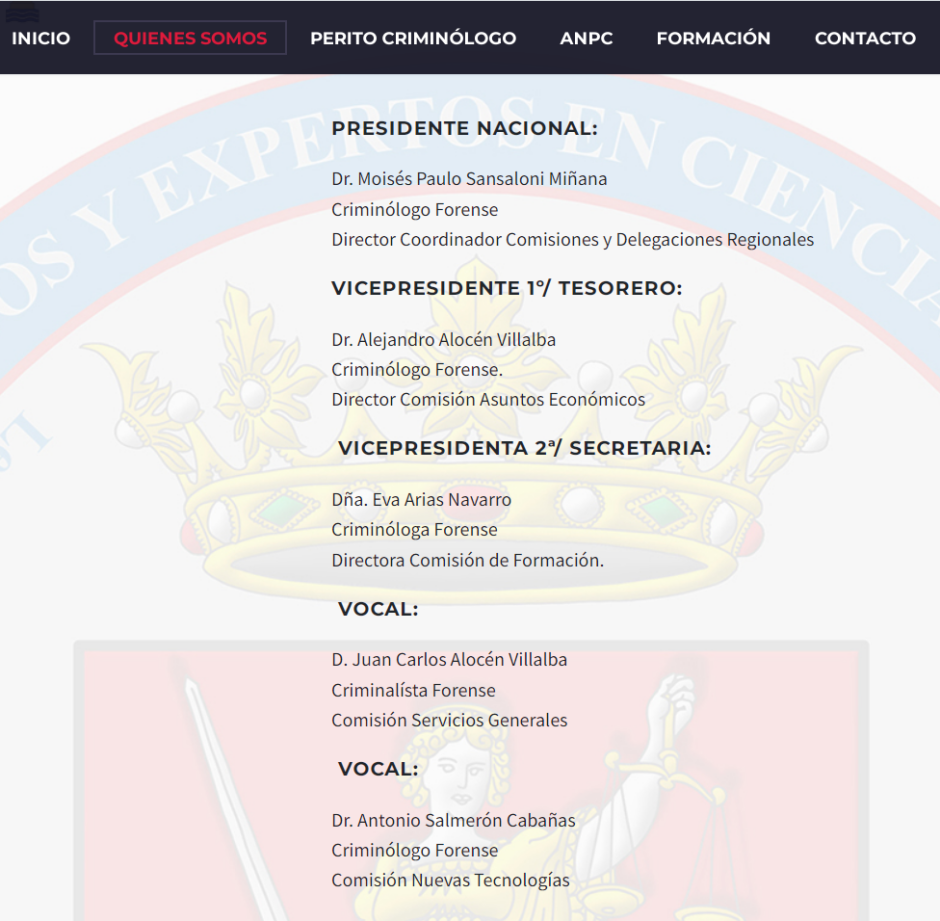

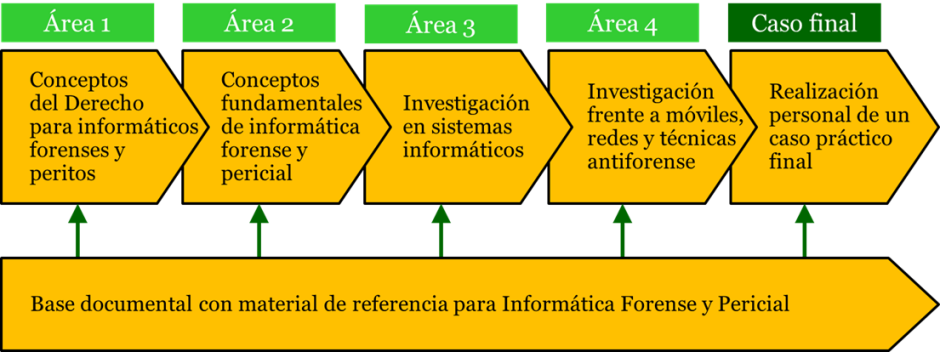

Informática Forense y Pericial

realización: 29 de agosto de 2012 | actualización: 20 de septiembre de 2012

Desarrollo de los programas de formación para los Títulos Propios de

Máster,

Especialista y

Experto

en Informática Forense y Pericial del

Campus Internacional de Inteligencia y Pericia

(CIIP).

Las 3 titulaciones se imparten de forma online y

su plazo de matrícula está abierto a lo largo de todo el ciclo académico.

Dentro del marco de este proyecto se incluye el desarrollo del sitio web

dedicado a estos cursos de formación en

Informática Forense y Pericial,

donde se puede encontrar información sobre:

los objetivos y motivación de los 3 programas de formación,

su estructuración en áreas de conocimiento y el recorrido por las áreas,

los módulos de las áreas, su descripción y objetivos, los créditos

European Credit Transfer System (ECTS) de los 3 títulos, los de sus áreas

de conocimiento y módulos, el detalle de sus temas con sus créditos ECTS

y, también, se describe del material formativo, documentación, esquemas,

textos legales, casos prácticos y la bibliografía básica de soporte.

-

Author & director of the Master in Computer Forensics,

CIIP,

Cambridge,

2012-2024.

-

Autor y director del Máster en Informática Forense y Pericial,

CIIP,

Cambridge,

2012-2024.

Ir al Campus Internacional de Inteligencia y Pericia

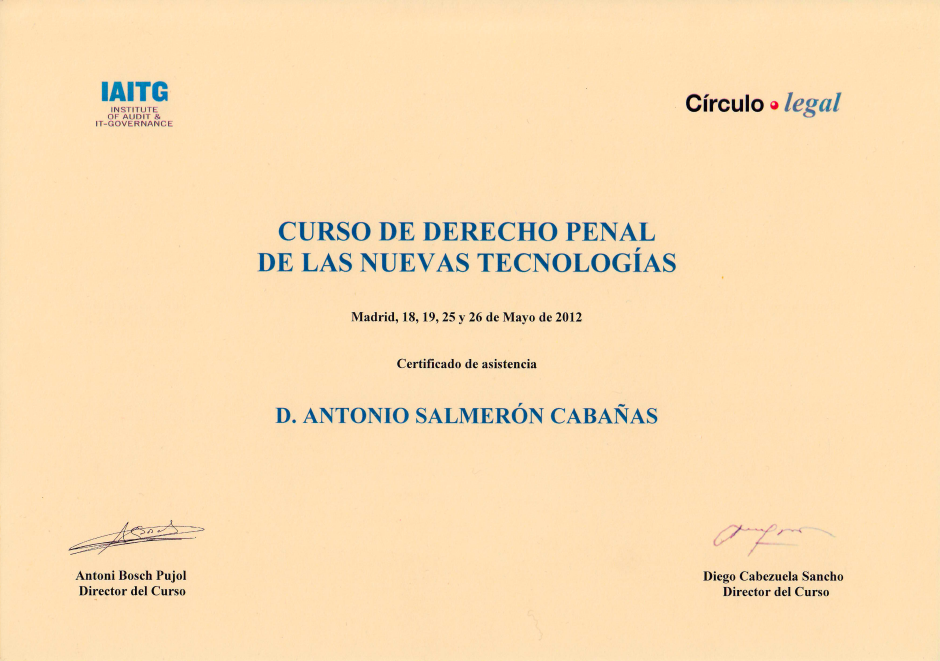

Derecho Penal y las Nuevas Tecnologías

realización: mayo de 2012 | actualización: 9 de febrero de 2024

Asisto al curso organizado por

Círculo Legal y

el Institut of Audit and IT Governance (IAITG)

con la colaboración de la Fundación Tejerina,

dedicado al estudio, desde una óptica práctica,

de los cambios que las nuevas tecnologías producen

en el Derecho Penal y en la investigación de los delitos.

-

«Criminal Law of the New Technologies», taught by

judges and prosecutors of the Supreme Court,

Legal Circle,

Madrid,

May of 2012.

-

«Derecho Penal de las Nuevas Tecnologías», impartido por

Magistrados y Fiscales del Tribunal Supremo,

Círculo Legal,

Madrid,

mayo de 2012.

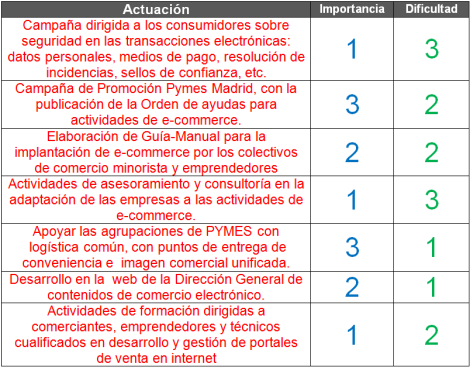

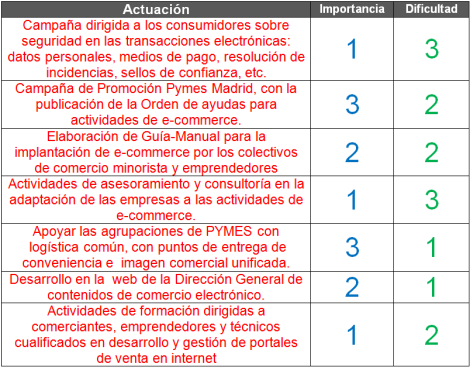

Plan de Comercio Electrónico de la Comunidad de Madrid

realización: 18 de marzo de 2012 | actualización: 21 de septiembre de 2012

Entre estos meses de febrero y marzo de 2012,

he participado como experto en

el Grupo de Trabajo de Logística y Distribución para

el Plan de Promoción del Comercio Electrónico de

la Dirección General de Comercio, de

la Consejería de Economía y Hacienda de

la Comunidad de Madrid.

Este llamado Programa DeC está dirigido a

las pequeñas y medianas empresas (PYMES), autónomos y emprendedores

del sector del comercio de la Comunidad de Madrid,

con el objetivo institucional de

aprovechar su potencial en la generación de crecimiento y empleo y

para mejorar la competitividad de su tejido empresarial.

-

Collaborator for E-Commerce Plan of the Economy Department of the Community of Madrid, 2012.

-

Colaborador para el Plan de Comercio Electrónico de la Consejería de Economía de la Comunidad de Madrid, 2012.

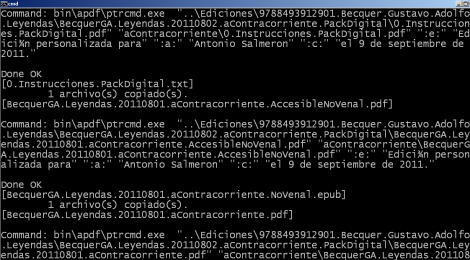

Personalizar con A-PDF Text Replace

realización: 9 de septiembre de 2011 | actualización: 9 de septiembre de 2011

He empezado a utilizar A-PDF Text Replace que

es una herramienta muy útil para modificar documentos en formato PDF.

Por ejemplo, sirve para personalizar un mismo documento PDF para diferentes personas.

Para ello se puede poner en el documento PDF original

un texto que haga de campo a reemplazar, por ejemplo, _NOMBRE_, y

luego utilizar A-PDF Text Replace para cambiar _NOMBRE_ por

el nombre de cada persona.

Como con A-PDF Text Replace se pueden dar varias órdenes de cambio en la misma ejecución,

se puede personalizar simultáneamente el nombre, la fecha, la dirección u otros campos.

A-PDF Text Replace es también invocable desde la línea de mandatos,

por lo que puede invocarse con System() desde el lenguaje TOL,

como se muestra en el siguiente código:

///////////////////////////////////////////////////////////////////

Real PdfReplace(Text inpPth, // Input file path

Text outPth, // Output file path

Text namCus) // Customer name

///////////////////////////////////////////////////////////////////

{

Text pdfCmd = W("bin/apdf/ptrcmd.exe"); // A-Pdf executable path

Text inpDos = Q(W(inpPth));

Text outDos = Q(W(outPth));

Text forOld = Q(":e:");

Text namOld = Q(":a:");

Text dteOld = Q(":c:");

Text forNew = Q("Edición personalizada para");

Text namNew = Q(namCus);

Text dteNew = Q("el "+Dte2Spa(Now)+"."); // Spanish date

Text cmdTxt = pdfCmd+" "+inpDos+" "+outDos+" "+

forOld+" "+forNew+" "+

namOld+" "+namNew+" "+

dteOld+" "+dteNew;

Real sysRet = System(cmdTxt); // Execute

sysRet // Returns

};

Donde Q() y W() son dos pequeñas funciones donde

la primera pone comillas en los caminos de los ficheros,

por si esos nombres contuvieran caracteres blancos, y

la segunda cambia el slash normal ( / ) por el back slash de los caminos de Windows ( \ ).

///////////////////////////////////////////////////////////////////

Text Q(Text txt) // Text

///////////////////////////////////////////////////////////////////

{ Char(34)+txt+Char(34) };

///////////////////////////////////////////////////////////////////

Text W(Text txt) // Text

///////////////////////////////////////////////////////////////////

{ Replace(txt, "/", "\\") };

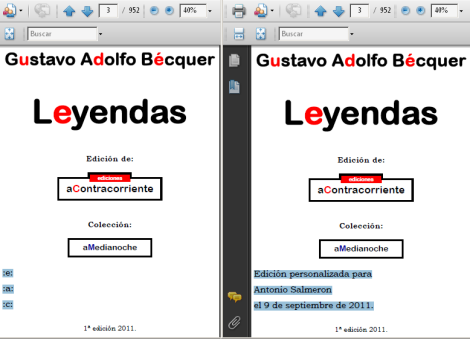

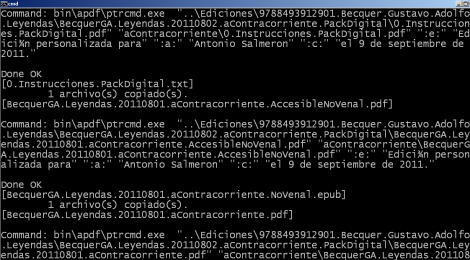

La siguiente ventana muestra

la ejecución de A-PDF Text Replace invocado desde TOL.

El mandato que se esta ejecutando en la ventana es:

bin\apdf\ptrcmd.exe

"..\Ediciones\9788493912901.Becquer.Gustavo. Adolfo.Leyendas\

BecquerGA.Leyendas.20110802.aContracorriente.PackDigital\BecquerGA.

Leyendas.20110801.aContracorriente.pdf"

"aContracorriente\BecquerGA.Leyendas.20110801.aContracorriente.pdf"

":e:" "Edición personalizada para"

":a:" "Antonio Salmeron"

":c:" "el 9 de septiembre de 2011."

Donde ":e:", ":a:" y ":c:" son los campos que se utilizan para

ser remplazados por los texto de personalización.

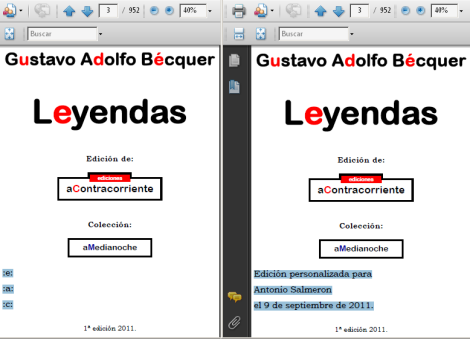

El resultado es el que se muestra en la siguiente imagen.

A la izquierda el PDF original,

a la derecha el PDF modificado.

Es la personalización de una edición digital de las Leyendas de Gustavo Adolfo Bécquer.

Los campos seleccionados en el primer PDF corresponden a las marcas,

los campos seleccionados en el segundo PDF a los valores finales de la personalización.

Ver más herramientas de A-PDF

Buscar datos en Mozilla Backup de Thunderbird

realización: 5 de septiembre de 2011 | actualización: 5 de septiembre de 2011

Para buscar datos (direcciones, teléfonos, fechas de envío, etc.)

que estaban en un email borrado,

pero guardado en un backup realizado con Mozilla Backup (MozBackup)

para el sistema de gestión de correo electrónico Thunderbird,

no es necesario restaurar el backup.

Lo que es especialmente relevante para backups de más de un Gbyte.

El fichero de MozBackup (extensión .pcv) es un fichero comprimido,

que se puede abrir con 7-zip, también con WinZip y WinRar, y

volcar todo su contenido a un directorio temporal.

Este directorio sigue la estructura de los directorios de

trabajo de Thunderbird.

Una vez volcado se puede navegar, manualmente,

por el árbol de directorios

para localizar la carpeta en la que se cree que esta el correo.

Esta navegación también se podría hacer dentro del fichero comprimido,

pero me resulta mucho más incómoda.

Si no se sabe muy bien donde pueden estar los datos o los correos electrónicos,

se puede localizar el fichero o los ficheros que los contienen con

alguna utilidad de búsqueda recursiva en un árbol de directorios y

aquellos patrones de búsqueda que creamos más significativos.

En estos casos, en Windows, utilizo grep.exe de GNU (GnuGrep)

con la opción -r de recursivo, por ejemplo:

\bin\gnuwin32\bin\grep -r -l -c "asolver.com" ImapMail

para buscar correos del dominio asolver.com sólo en la carpeta

ImapMail, lo más cómodo es buscarlo en el total (.).

Hay que tener en cuenta que el caracter arroba (@) típico de las direcciones de correos

a veces aparece como tal en las cabeceras de los correos electrónicos y

otras como

=40 siendo el 40 el código ASCII hexadecimal de la arroba

(64 decimal, el anterior a la A y el doble que el caracter blanco),

como sucede en el cuerpo de los correos.

Por lo que se podrían probar búsquedas como

"asalmeron@asolver.com" o "asalmeron=40asolver.com".

Si finalmente hay que examinar visualmente

el fichero o los ficheros localizados por grep.exe,

como son ficheros planos,

pueden abrirse con un editor de textos para buscar la información localmente.

De todos los editores posibles utilizo para ello Notepad2.

Mozbackup,

Thunderbird,

7-zip,

GNU Grep Win32 y

Notepad2

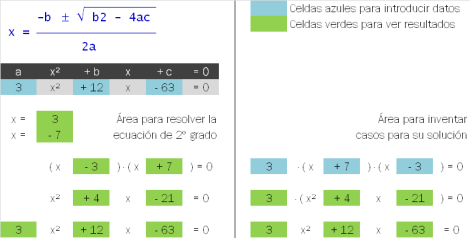

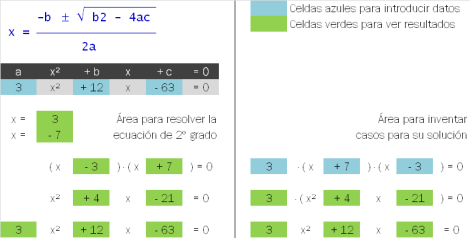

Resolver ecuaciones de segundo grado

realización: 17 de agosto de 2011 | actualización: 17 de agosto de 2011

Pequeño fichero Excel (Libro de Excel 97-2003) con una sola hoja de

cálculo que permite resolver las ecuaciones de segundo grado y

obtener sus dos soluciones.

En la parte izquierda de la hoja de cálculo,

a partir de la ecuación sen encuentran sus 2 raices,

se factoriza la ecuación de segundo grado como

(x - 1ª raiz) . (x - 2ª raiz) y

se vuelve a reconstruir la ecuación para comprobar que todo es correcto.

La parte derecha de la hoja de cálculo,

permite generar problemas sencillos de ecuaciones de segundo grado

para su posterior solución.

Las celdas azules son para introducir los datos y

las celdas verdes para ver los resultados.

Descargar el Excel para resolver ecuaciones de 2º grado

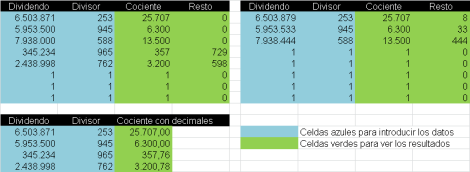

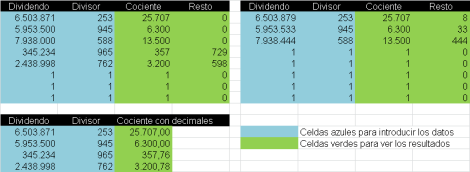

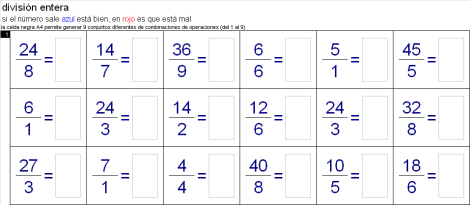

Comprobar divisiones con resto

realización: 10 de julio de 2011 | actualización: 10 de julio de 2011

Pequeño fichero Excel (Libro de Excel 97-2003) con una sola hoja de

cálculo que permite comprobar el cociente y el resto de divisiones.

También permite comprobar divisiones cuando se pide calcular el cociente

con 2 decimales.

Las celdas azules son para introducir los datos y

las celdas verdes para ver los resultados.

Descargar el Excel para comprobar divisiones

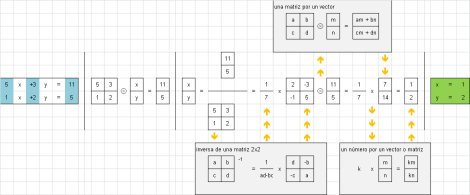

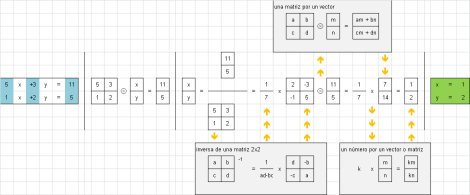

Ecuaciones de 2 a 6 incógnitas con matrices

realización: 21 de enero de 2011 | actualización: 15 de agosto de 2011

Fichero Excel (Libro de Excel 97-2003) con 6 hojas de cálculo

para resolver pequeños sistemas de ecuaciones de 2 a 6 incógnitas.

En las 2 primeras hojas de cálculo

se resuelven sistemas de 2 ecuaciones de con 2 incógnitas.

En la primera mediante la función Excel inversa de una matriz y

en la segunda mediante el cálculo paso a paso de la inversa de

una matriz 2x2.

En las 4 siguientes hojas de cálculo

se resuelven sistemas de ecuaciones con 3, 4, 5 y 6 incógnitas,

mediante la función Excel inversa de una matriz (MINVERSA()).

Las 2 últimas hojas de cálculo (con 5 y 6 ecuaciones)

también contienen un área de celdas para la comprobación de los resultados.

Estas hojas de cálculo Excel permiten conocer el mecanismo de cálculo

empleado, mediante:

-

su diseño de cálculo por fases, especialmente en la 2ª hoja,

con datos de entrada, resultados intermedios y resultados finales y

-

las fórmulas visibles dentro de sus celdas.

La función Excel MINVERSA() es una fórmula matricial que

afecta a varias celdas de forma simultánea.

La introducción de este tipo de fórmulas matriciales

es diferente al de las funciones normales de Excel.

Los pasos para introducir una fórmula matricial son:

-

Se selecciona el rango de celdas que ocupará la matriz destino,

por ejemplo, un rango 2x2,

empezando por la celda de la esquina superior izquierda.

-

Se pulsa la tecla F2 que

activa la posibilidad de introducir una fórmula

en la celda de la esquina superior izquierda

(que es por la que se comenzó la selección).

Entonces se teclea la fórmula matricial,

por ejemplo: =MINVERSA(T6:U7).

-

Una vez tecleada la fórmula y

con el rango de celdas destino que sigue seleccionado

se pulsan simultáneamente las teclas Control+Shift+Intro.

Entonces la fórmula matricial se expande a todo el área seleccionada y

Excel la visualiza entre corchetes,

como {=MINVERSA(T6:U7)},

para señalar que es una fórmula matricial.

-

Nota:

Una vez tecleada la fórmula no hay que pulsar Intro,

ni el botón llamado introducir (v) que

está a la izquierda del área de introducción de fórmulas.

Descargar el Excel para resolver ecuaciones con matrices

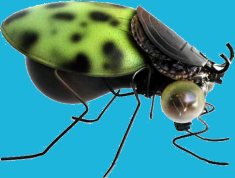

artthropods.net: bichos de material reciclado

realización: 14 de noviembre de 2010 | actualización: 19 de septiembre de 2011

Artthropods.net es

una web deliciosa de Miguel Ángel Nuñez.

Fue desarrollada en 2002 por un querido amigo suyo que ya no está entre nosotros.

Inicialmente estaba albergada en un servidor de Arsys,

pero tras una actualización por parte de Arsys de la versión del sistema operativo de ese servidor,

la web dejo de funcionar

y tampoco es que los de Arsys proporcionaran mucha ayuda a sus recuperación.

En 2010, a partir de un backup de la web,

corregí en su código todo aquello que hacía que hubiera dejado de funcionar,

cree el nuevo dominio Artthropods.net,

la albergue en un servidor mio y, desde entonces, vuelve a estar operativa.

La web contiene una fabulosa tienda y un museo de bichos realizados a mano por Miguel Ángel Núñez con material reciclado.

Aunque agrupados por especies (Insectos, Crustáceos y Arácnidos) y

familias

(Halogenatae, Cohoniaceae, Bichiidae, Escaracazolae, Saltavoltiaceae, Viniliidae, Picnicpterae, Latharontidae, Microchupterae,

Anthiparridae, Calzadoriaceae, Recycliidae, Macrochupopterae, Scorpioniidae, Malahosstiaceae, Calandrakae, Casualidea,

Malakostrakae y Aranyas),

cada bicho es totalmente diferente y con nombre propio:

Agaffosperma capronna, Anthiparris vacuum,

Bishogordus tontorronis, Bombus jamacucus,

Cascanut goliath, Chupoptera grappadora,

Duploclippaa primigenia, Escaracazus inox,

Fagopringatta seductora, Fornica docarallo,

Gamba manolopozus, Grillotata longuipatta,

Lacusta coloreatta, Lataronthias mejillonii,

Malahossssthia elegans (hembra y macho),

Neuropteris fabafacialis, Onthocazus lathicornis,

Patachunga blueyes, Pompilia sublimis,

Raybannia lenti-macarria, Recyclida miniwattia,

Saltavoltios chamaleon, Scorpio dipostre,

Tabanus inox, Tippex magnum,

Vespachappa splendens, Vespina brebis,

Zumbix violacea, Zumbonia lunaria, etc.

Pueden adquirirse a unos precios muy razonables para el trabajo que tienen y lo bonitos que son.

Tanto si tienes interés por conseguir algún ejemplar

(el mio es como el que aparece en la imagen de la izquierda)

o sólo por contemplar los que se muestran en su Museo

te recomiendo que visites la web.

Esta web está desarrollada en HTML con JavaScript para el lado del cliente y con

Active Server Pages (ASP) para el lado del servidor,

soportado por una base de datos Access de Microsoft y

por los dos últimos productos ha de albergarse en

un servidor Windows con Internet Information Services (IIS).

Ver los bichos de material reciclado de Miguel Ángel Númez

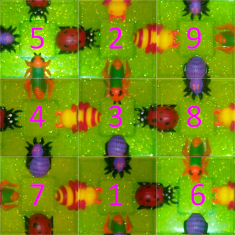

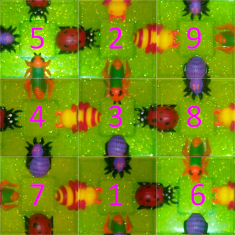

Solución a un 3D Squares

realización: 27 de septiembre de 2010 | actualización: 7 de septiembre de 2011

Hay puzzles que les regalan a los niños que parecen triviales y no lo son,

a veces ni para los niños ni para los adultos.

Para mi este es un caso claro.

Para resolverlo tuve que programar un solucionador en

TOL que

no resulto muy complicado.

De hecho mucho menos complicado que resolver manualmente el puzzle 3D Squares.

Aunque el código completo junto con su traza de ejecución puede obtenerse

en PDF al final de este post,

pongo a continuación en algoritmo recursivo fundamental.

Este algoritmo encuentra 4 soluciones iguales, pues unas resultan de un

giro de 90º de otras:

///////////////////////////////////////////////////////////////////

Real SolCua(Set entSol, Set entPie) // Resuelve

///////////////////////////////////////////////////////////////////

{

Real crdSol = Card(entSol);

Text Write(FormatReal(crdSol,"%.0lf"));

If(EQ(crdSol, 9), SolVer(entSol), // Ha encontrado una solucion

{ // Busca soluciones

EvalWhile(entPie, Real(Text unoPie)

{

Set salPie = entPie - [[unoPie]];

Set varPie = VarAll(unoPie);

EvalWhile(varPie, Real(Text unoVar)

{

Set salSol = entSol << [[ unoVar ]];

If(SolBue(salSol), SolCua(salSol, salPie), FALSE)

})

})

})

};

Programación de la solución del 3D Squares y traza de ejecución

Ver el problema y las 4 soluciones del 3D Squares

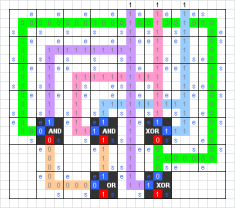

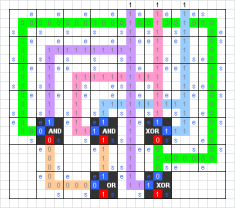

Puertas lógicas AND, OR, XOR y Sumador en Excel

realización: 29 de julio de 2010 | actualización: 3 de septiembre de 2011

Ejemplo de programación en Excel de puertas lógicas AND, OR, XOR y

Sumadores con acarreo (la versión es la de Excel 97-2003).

En la primera hoja se ven las puertas lógicas

AND (Y), OR (O) y XOR (O exclusivo) y sus tablas de verdad.

En la segunda hoja un sumador con acarreo y su tabla de verdad construido

mediante las puertas anteriores.

La tercera hoja contiene 3 versiones de sumadores con acarreo similares

al de la hoja anterior.

En la cuarta hoja se implementa un sumador de 3 bits a partir de

los sumadores anteriores.

Incluye todas las pistas de conexión entre las puertas,

con diferentes colores, para ver la transmisión de la información.

Puertas lógicas AND, OR, XOR y Sumador con acarreo en Excel

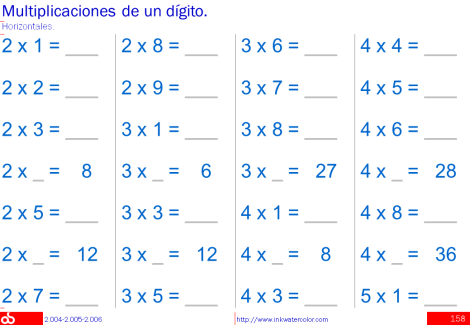

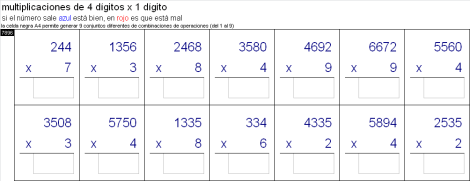

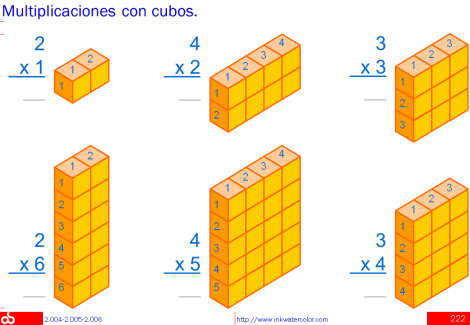

Tablas de multiplicar y multiplicaciones

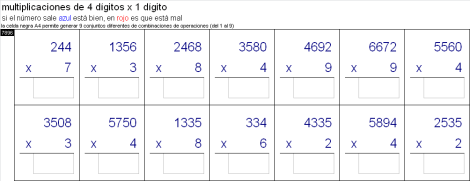

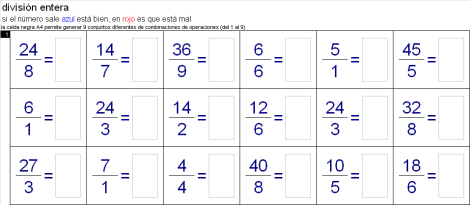

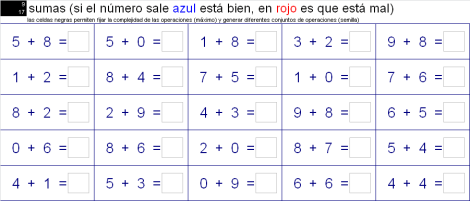

realización: 14 de febrero de 2010 | actualización: 22 de abril de 2011

Fichero Excel de Microsoft con tablas de multiplicar y multiplicaciones

de 1, 2, 3, 4 y 5 dígitos por 1 dígito.

Plantea multiplicaciones, hay que teclear los resultado e

informa de los errores de tal manera que

si el número sale azul es que la multiplicación está bien,

si sale en rojo es que está mal.

En cada una de las 6 hojas Excel hay una celda negra que permite generar

9 conjuntos diferentes de combinaciones de operaciones (del 1 al 9).

Las soluciones también pueden consultarse en la parte inferior

de cada hoja Excel en el área coloreada de gris.

La versión es la de Excel 97-2003.

Excel con tablas de multiplicar y multiplicaciones

Informes estadísticos para ANECA

realización: 9 de junio de 2009 | actualización: 2 de septiembre de 2011

Automatización de la generación de informes estadísticos sobre los resultados de la evaluación

del profesorado universitario

para la Agencia Nacional de Evaluación de la Calidad y Acreditación

(ANECA).

Realizado en colaboración con Cetiver,

es un desarrollo en lenguaje TOL,

contra una base de datos SQL-Server,

con generación de informes en formato PDF y

envío automático de los informes por email a 44 Vicerrectores de Universidades Españolas.

Se trata de un programa de los que llamo nocturnos,

capaz de funcionar sólo, por las noches,

activado por el programador de tareas del sistema,

sin necesidad de intervención humana.

Fue la primera aplicación real de mis experimentos de generación de informes PDF,

desde el lenguaje TOL,

mediante la creación de páginas HTML intermedias y su conversión a PDF con

Two Pilots.

El código específico de esta aplicación es privado,

por lo que sólo incluyo un pequeño ejemplo de las 15 líneas de código de la

función de llamada a Two Pilots,

para la conversión de un informe HTML a PDF,

que es completemente genérico y

útil para el que desee invocar a este conversor en su modo de línea de mandatos.

///////////////////////////////////////////////////////////////////

Real PdfBuild(Text filInp, // Input html file

Text filOut) // Output pdf file

///////////////////////////////////////////////////////////////////

{

If(Not(FileExist(filInp)), FALSE, // Nothing to do

{

// with back slash

Text dosInp = Replace(PdfAbs+filInp, "/", "\\");

Text dosOut = Replace(PdfAbs+filOut, "/", "\\");

Text cmdTxt = PdfExe+" "+ // Executable pdf convertor

dosInp+" "+ // Input file

dosOut+ // Output file

" /jpeg 100 /author Aneca";

Text WriteLn(" Pdf: "+filOut);

System(cmdTxt) // Execute html to pdf conversion

})

};

///////////////////////////////////////////////////////////////////

PutDescription(

"Returns true if can create a pdf file filOut from "+

"an html file filInp.",

PdfBuild);

///////////////////////////////////////////////////////////////////

Conversor de HTML a PDF de Two Pilots

Contador de separadores de campos

realización: 15 de agosto de 2008 | actualización: 10 de septiembre de 2011

En una gran aseduradora nos volcaban ficheros inmensos de datos de

operaciones sobre polizas desde el host,

ficheros con millones de registros.

Eran ficheros planos y ellos mismos elegían el carácter separador de

campos.

Esos ficheros los subíamos, a su vez, a otra base de datos que

los cargaba utilizando, para interpretar la separación de campos,

el carácter indicado en cada caso.

Esta carga se realizaba empleando el programa de carga suministrado

junto con el sistema de gestión de la base de datos.

El proceso de carga era lento y, además,

con frecuencia, el carácter que habían elegido,

aparecía en algún campo de texto de algún registro.

Por ejemplo, elegían el asterisco y

algunos campos de observaciones contenían asteriscos.

Al llegar al primer registro con más separadores de los esperados

el proceso de carga abortaba tras horas de ejecución.

La solución era programar un comprobador de ficheros,

muy rápido, que antes de iniciar el proceso de carga,

comprobara que todas las líneas del fichero contuvieran el mismo

números de caracteres separadores de campo,

asumiendo como correcto el número de separadores de la primera línea del fichero.

Y sólo comenzar la carga a la base de datos tras comprobar que

el fichero era correcto.

Hacía ya mucho tiempo que no programaba en C y

esta era una ocasión para volver a él.

El programa se llama chksep.exe,

esta hecho en lenguaje C en pocas horas,

por lo que seguro que se puede mejorar.

Se ejecuta como

chksep 42 < fichero.txt,

donde el 42 es el código ASCII del caracter *,

que era el separador de campos habitual,

aunque se puede elegir cualquier otro carácter,

por ejemplo,

chksep 59 < fichero.txt,

para el punto y coma.

El programa visualiza las líneas donde

el número de separadores de campo es diferente al de la primera línea.

En un computador portatil normal este programa es capaz de revisar

un Giga en 2 minutos 15 segundos,

lo que equivalía con los ficheros reales que nos daban a

unos 800.000 registros por minuto.

Por lo que en 5 ó 10 minutos se podía evitar que luego abortara una carga de horas.

El programa también cuenta el número de líneas del fichero.

A continuación pongo el ciclo principal del programa y

en el fichero PDF adjunto a este post el código fuente completo.

Me gustan mucho los programas eficaces de pocas líneas de código y

que sean eficientes ya lo considero un regalo.

while((chrInp=getc(stdin)) != EOF)

{

if(chrInp==sepChr) { sepCnt++; } /* Es un separador */

else if(chrInp==EOL) /* Es un salto de linea */

{

if(linCnt==1) /* Estabamos en la 1ª linea */

{

sepFst = sepCnt; /* Referencia para el resto de lineas */

printf("\n[%d] [%s] en la primera linea.", sepFst, sepStr);

}

else /* Linea normal */

{

if(sepFst!=sepCnt) /* Faltan o sobran separadores */

{

printf("\nlinea %d: [%d] [%s] en vez de [%d].",

linCnt, sepCnt, sepStr, sepFst);

}

}

linCnt++; /* Incrementar el contador de lineas */

sepCnt = 0; /* Poner a cero el contador de separadores */

}

}

printf("\nProcesadas [%d] lineas.", linCnt);

Ver el código fuente C completo del contador de separadores de campo

Página del abogado Bartolomé Quesada Valles

realización: 10 de agosto de 2008 | actualización: 5 de agosto de 2011

Realización del registro de dominio .es, diseño, maquetación, desarrollo y mantenimiento en internet de

la primera versión de la página web del despacho de abogados de Bartolomé Quesada Valles.

Bartolomé Quesada Valles es abogado,

tiene más de 20 años de ejercicio profesional

y está colegiado en el Ilustre Colegio de Abogados de Madrid (ICAM).

Esta primera versión de la página web estuvo operativa

desde mediados del verano de 2008 hasta inicios del verano de 2010.

Actualmente está en funcionamiento la segunda versión de esta página web,

que ha sido desarrollada en Joomla! por Luis Torrijos.

Ver el versión actual

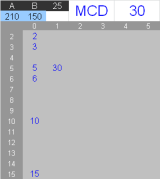

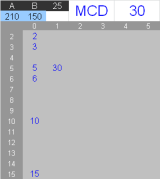

Máximo común divisor de 2 números

realización: 26 de julio de 2008 | actualización: 22 de abril de 2011

Ejemplo de hoja Excel para calcular el máximo común divisor (MCD) entre 2

números.

El fichero Excel de Microsoft está formado por una sola hoja de cálculo en

la que los 2 números para los que se quiere calcular su máximo común

divisor se introducen en las celdas azules.

La hoja Excel visualiza en la zona gris los divisores encontrados y

arriba en grande y azul el máximo común divisor.

Este ejemplo Excel tiene limitaciones en el tamaño de los números y

el método de cálculo.

La versión es la de Excel 97-2003.

Cálculo en Excel del máximo común divisor (MCD) de 2 números

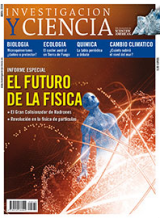

Pedro Reina, cifras y letras

realización: abril de 2008 | actualización: 20 de agosto de 2011

Tuve la suerte de conocer a Pedro Reina en 1991,

en la primera edición del curso Sistemas expertos en la empresa.

En 1992, Pedro acometió el desarrollo de dos programas cuyo

objetivo era resolver los problemas del programa televisivo «Cifras y Letras».

Primero desarrollo el programa que resolvía el problema de las cifras y luego el de las letras.

Durante ese tiempo pude discutir con Pedro sus enfoques de solución a esos dos problemas.

En abril de 2008,

Juan M. R. Parrondo dedicó su sección de Juegos Matemáticos de la revista Investigación y Ciencia,

a los dos algoritmos desarrollados por Pedro Reina para resolver los problemas de «Cifras y Letras».

En este artículo, Pedro Reina me cita amablemente

a la hora de describir el mecanismo usado para resolver el problema de las letras:

«...la solución que nos ofrece Reina es muy sencilla,

gracias a una idea sumamente ingeniosa

que el propio autor atribuye al profesor de inteligencia artificial Antonio Salmerón...».

Juan M. R. Parrondo,

«Cifras y Letras de Pedro Reina»,

sección de Juegos matemáticos,

revista Investigación y Ciencia (traducción española de Scientific America),

ISSN 0210-136X,

número 379,

páginas 90-91,

Barcelona, abril de 2008.

-

Cited

in «Numbers and Letters of Pedro Reina»

by Juan M. R. Parrondo,

Reseach & Science Magazine,

Barcelona,

April of 2008.

-

Citado

en «Cifras y Letras de Pedro Reina»

por Juan M. R. Parrondo,

Revista Investigación y Ciencia,

Barcelona,

abril de 2008.

Leer el artículo en PDF

Análisis sensorial de sistemas

realización: marzo de 2008 | actualización: 4 de diciembre de 2015

Cuaderno con casos prácticos:

psoe.es y pp.es en la campaña electoral 2008 y otros casos de estudio,

elaborado del 21 al 29 de febrero de 2008.

Cuando somos niños creemos que los personajes de los libros, de las obras de teatro

o de las películas hablan por sí mismos, sin embargo, pronto aprendemos que son

los autores los que hablan a través de ellos y que, por tanto, podemos intentar

conocer y comprender a los autores a través de sus obras.

Cuando interactuamos con sistemas a menudo seguimos creyendo, como los niños,

que son dichos sistemas los que dicen y hacen y no los autores que los programaron

y las entidades que los crearon.

Como en cualquier creación humana, podemos conocer y comprender a las

entidades, su dueños, directivos y trabajadores a través de los comportamientos,

acciones, mensajes y errores de los sistemas que fabrican o de los que se sirven. A

menudo las verdaderas ideas y sentimientos de las personas y los grupos se pueden

ver mejor reflejadas en sus sistemas que en sus mensajes comerciales, ya que

mientras en otros tipos de comunicación se presta especial atención a los mensajes

que se emiten, en los sistemas hay 2 razones por la que los sentimientos auténticos

de la organización afloran con mayor facilidad:

-

la atención a los aspectos tecnológicos, la subcontratación y las dificultades de

desarrollo restan atención al cuidado de los mensajes que se emiten diciendo

más directamente lo que se piensa y

-

la conexión directa de muchos sistemas con el aparato de la organización hace

que a través de esas conexiones aflore su verdadera personalidad.

-

Author of

«Sensory analysis of systems»,

Intellectual Property Register,

number 16/2009/5854,

Madrid,

March of 2008.

Essay on the analysis of computer systems through the senses and about how to lear this technique.

-

Autor de

«Análisis sensorial de sistemas»,

Registro de la Propiedad Intelectual,

número 16/2009/5854,

Madrid,

Marzo de 2008.

Ensayo sobre el análisis de sistemas informáticos a través de los sentidos y sobre el aprendizaje de esta técnica.

Ver el cuaderno completo en PDF

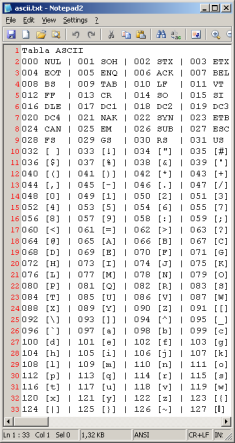

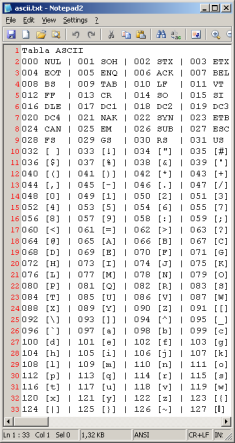

Tabla ASCII generada con TOL

realización: 27 de noviembre de 2007 | actualización: 10 de septiembre de 2011

Este es un programa sencillo,

orientado al aprendizaje del lenguaje

TOL.

El programa escribe un fichero con los 128 primeros caracteres

de la tabla ASCII.

Los 32 primeros son caracteres especiales por lo que sus siglas

se almacenan en un conjunto

TOL (Set).

Los siguientes caracteres se generan mediante la función TOL Text Char(Real asc).

Se muestra a continuación el código completo del programa que

también se puede consultar en el documento PDF adjunto a este post,

se incluye junto con el código el fichero resultante con la tabla ASCII.

Set AscFst =

[[

"NUL", "SOH", "STX", "ETX", "EOT", "ENQ", "ACK", "BEL",

"BS ", "TAB", "LF ", "VT ", "FF ", "CR ", "SO ", "SI ",

"DLE", "DC1", "DC2", "DC3", "DC4", "NAK", "SYN", "ETB",

"CAN", "EM ", "SUB", "ESC", "FS ", "GS ", "RS ", "US "

]];

Text fil = "ascii.txt";

Text WriteFile(fil, "Tabla ASCII");

Set cic = For(0, 127, Text(Real asc)

{

// Each 8 jump new line

Text new = If(asc % 4, "", "\n");

// The fist 32 are special characters

Text chr = If(LT(asc, 32), AscFst[asc+1], "["+Char(asc)+"]");

// Append character to file

Text lin = new + FormatReal(asc, "%03.0lf") + " " + chr +" | ";

Text AppendFile(fil, lin);

chr // Return the character

});

Ver el código fuente TOL y fichero de salida con la tabla ASCII

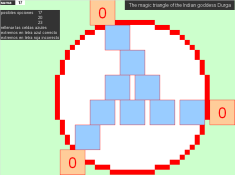

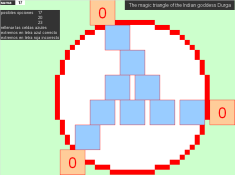

Triángulo mágico de la diosa hindú Durga

realización: 5 de mayo de 2007 | actualización: 21 de abril de 2011

Fichero Excel (Libro de Excel 97-2003) con 4 hojas de cálculo.

En la primera hoja se plantea resolver el problema del llamado

triángulo mágico de la diosa hindú Durga.

Hay que poner los números del 1 al 9,

todos y sin repetición,

en los 3 lados del triángulo,

de forma que los 3 lados sumen lo mismo.

En cada lado se ponen 4 números del 1 al 9 y

hay 3 celdas que son comunes a 2 lados,

teniendo en total 9 celdas.

Las 3 hojas siguiente muestran las 3 soluciones posibles.

En principio no habría que verlas hasta haber solucionado

por uno mismo el problema del triángulo.

Las operaciones se corrigen automáticamente.

Si el número introducido sale azul es que está bien y

si sale en rojo es que está mal.

En la primera hoja hay una celda de control que permite fijar

la solución que hay que buscar de entre las 3 existentes

(sin contar giros).

Excel para resolver el triángulo mágico de la diosa hindú Durga

PDF para resolver en papel el triángulo mágico de la diosa Durga

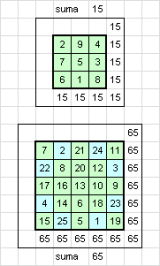

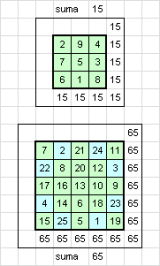

15 puzle (3x3) y 65 puzle (5x5)

realización: 5 de mayo de 2007 | actualización: 22 de abril de 2011

Fichero Excel de Microsoft

formado por una sola hoja de cálculo,

que contiene:

-

El llamado problema del 15 puzle,

de 3x3 celdas,

con todos los números de 1 al 9, uno por celda sin repetirse,

que suman siempre 15 tanto por filas, como por columnas y diagonales, y

-

El problema del 65 puzle, menos conocido que el anterior,

de 5x5 celdas,

con todos los números de 1 al 25, uno por celda sin repetirse,

que suman siempre 65 tanto por filas, como por columnas y diagonales.

En este fichero Excel se muestran ambos problemas ya resueltos.

La versión es la de Excel 97-2003.

Excel con el 15 puzle (3x3) y 65 puzle (5x5) resueltos

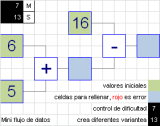

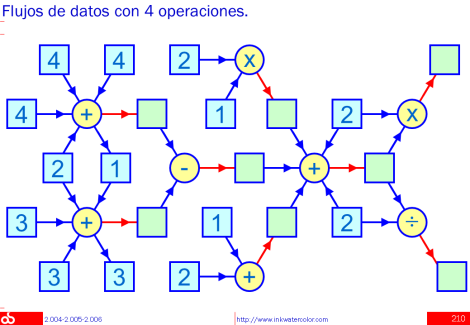

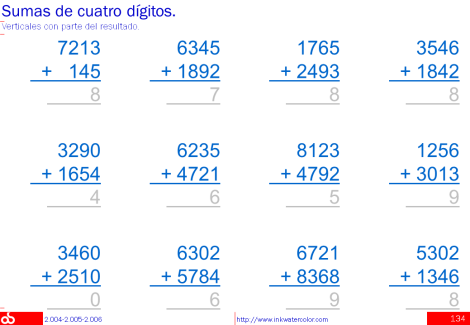

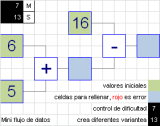

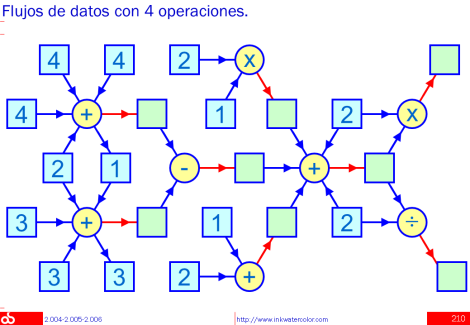

Mini sistema de flujo de datos

realización: 5 de noviembre de 2006 | actualización: 21 de abril de 2011

Fichero con dos hojas Excel (Libro de Excel 97-2003)

para practicar suma y resta con un mini sistema de flujo de datos.

Las dos hojas Excel contienen el mismo flujo de datos,

sólo difiere su anchura.

Las celdas de fondo verde claro son las que contienen los datos de partida.

En las celdas de fondo azul claro es en las que hay que introducir

los resultados.

Las operaciones se corrigen automáticamente.

Si el número introducido sale azul es que está bien y

si sale en rojo es que está mal.

En la hoja hay dos celdas negras de control,

arriba a la izquierda, que

permiten fijar la complejidad de las operaciones (máximo) y

generar diferentes conjuntos de operaciones.

Descargar el Excel con el sistema de flujo de datos

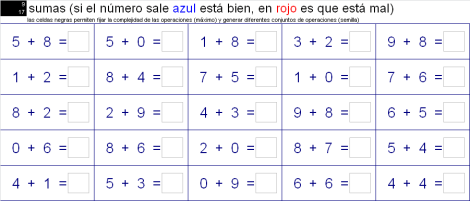

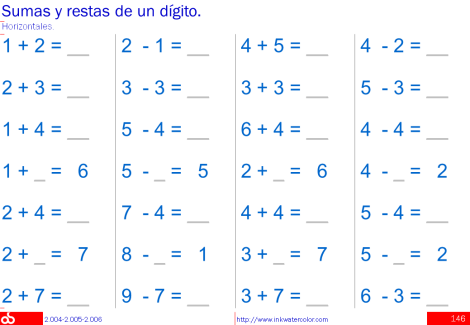

Operaciones básicas + - x /, disposición horizontal

realización: 4 de noviembre de 2006 | actualización: 21 de abril de 2011

Fichero Excel (Libro de Excel 97-2003) con 4 hojas de cálculo

para practicar sumas, restas, multiplicaciones y divisiones básicas.

Las operaciones se corrigen automáticamente.

Si el número introducido sale azul es que está bien y

si sale en rojo es que está mal.

En cada hoja hay dos celdas negras de control que

permiten fijar la complejidad de las operaciones (máximo) y

generar diferentes conjuntos de operaciones

(actuando de semilla para la generación aleatoria de operaciones).

Descargar el Excel para practicar la operaciones básicas

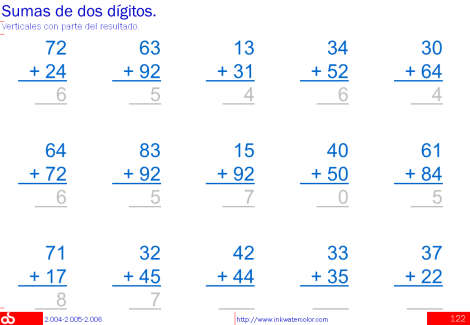

Operaciones básicas + - x /, disposición vertical

realización: 3 de noviembre de 2006 | actualización: 21 de abril de 2011

Fichero Excel (Libro de Excel 97-2003) con 7 hojas de cálculo

para practicar las operaciones básicas en disposición vertical:

-

Hoja de sumas básicas.

-

Hoja de restas básicas.

-

Hoja para practicar las tablas de multiplicar.

-

Dos hojas de multiplicaciones básicas.

-

Dos hojas de divisiones básicas.

Las operaciones se corrigen automáticamente.

Si el número introducido sale azul es que está bien y

si sale en rojo es que está mal.

En cada hoja hay una celda negra de control que

permiten generar nueve diferentes conjuntos de operaciones.

Descargar el Excel para practicar operaciones básicas

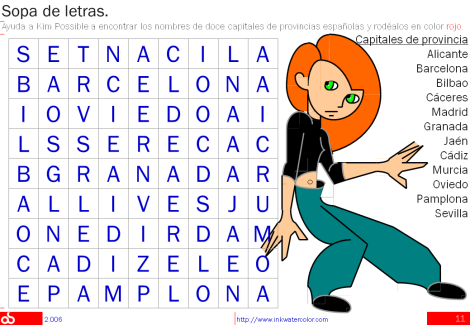

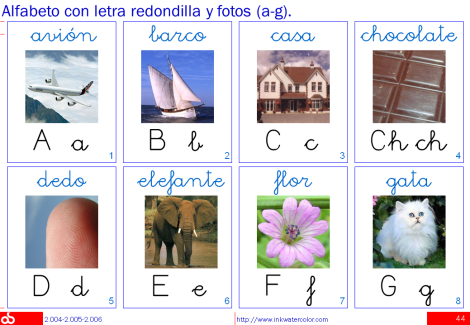

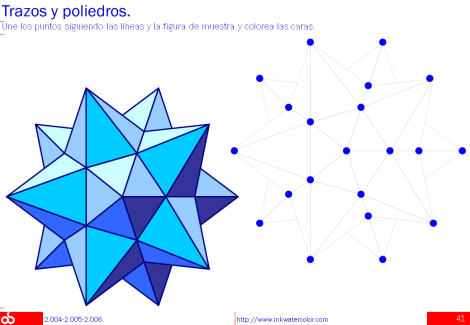

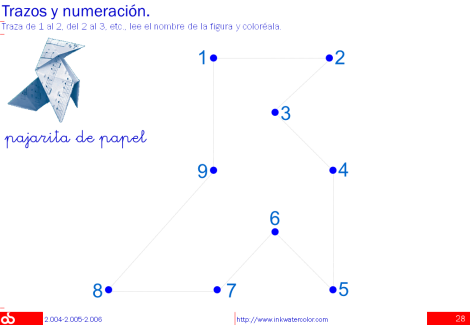

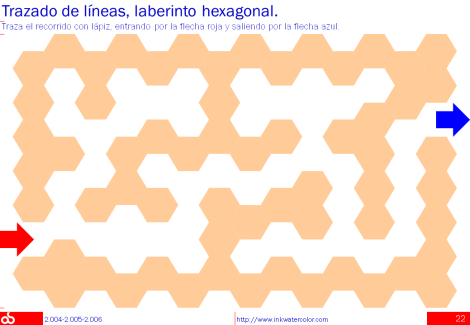

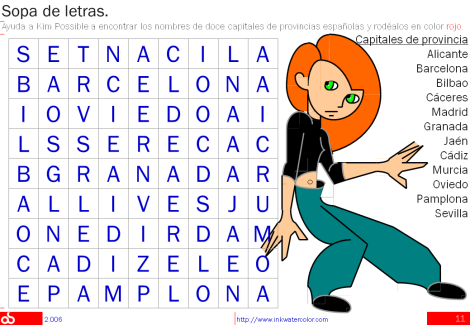

Superficie, trazos, sopas de letras, sudokus, series

realización: 15 de agosto de 2006 | actualización: 5 de septiembre de 2011

Cálculos de superficies de rectángulo y triángulos,

trazos con numeración y laberinto,

sopas de letras de capitales europeas, capitales de provincias españolas,

continentes, océanos,

animales carnívoros y hervívoros, mamíferos y reptiles,

tres sudokus y

series de cierto nivel.

Como curiosidad, el dibujo de Kim Possible está realizado únicamente